ChatGPTには情報漏えいリスクがある!個人・機密情報はどうやって守る?

ChatGPTを使うと個人情報や機密情報が流出する恐れがあると聞いて、二の足を踏んでいる方は多いのではないでしょうか。

しかし、ChatGPTの利便性を諦めてしまっては、業務効率化の大きなチャンスを逃してしまいます。また、情報漏えいのリスクを放置したままChatGPTを使うと、重大な事故につながる可能性があります。

本記事では、ChatGPTで起こりうる情報漏えいのケースを具体的に解説し、実際に情報流出が発生した事例も紹介します。さらに、情報漏えいリスクを抑えるための効果的な対策を複数提示します。

記事を読み終えた頃には、ChatGPTを安全に活用するためのポイントが理解でき、自社に合った対策を講じられるようになるでしょう。ChatGPTの力を借りて、業務の効率化と情報セキュリティの両立を実現しましょう。

監修者

SHIFT AI代表 木内翔大

「質の高いプロンプトでAIの能力をもっと引き出したい」「プロンプトのコツを知りたい」という方に向けて、この記事では「【超時短】プロンプト150選」を用意しています。

この資料ではジャンル別に150個のプロンプトを紹介しています。また、プロンプトエンジニアリングのコツも紹介しており、実践的な資料が欲しい方にも適しています。

無料で受け取れますが、期間限定で予告なく配布を終了することがありますので、今のうちに受け取ってプロンプトをマスターしましょう!

目次

ChatGPTで情報漏えいが起こる6つのケース

ChatGPTで情報が漏えいする場合、以下のケースが考えられます。

- 入力したデータが学習される

- バグによってチャット履歴が流出する

- OpenAIのミスによって情報が漏えいする

- マルウェアに感染して情報を抜き取られる

- 外部からの攻撃でGPTsの内容が流出する

- アカウント情報が流出する

これら6つを把握しておけば、ChatGPTでの情報漏えいリスクを格段に減らせるでしょう。

入力したデータが学習される

ChatGPTは、ユーザーが入力した情報を学習データとして活用するため、指示文であるプロンプトに記載した内容が外部に漏れる可能性が考えられます。

たとえば、企業の機密情報をChatGPTに入力した場合、その情報が学習され、他のユーザーとの対話において意図せず漏えいしてしまうリスクがあります。

とくに機密性の高い情報を扱う企業にとっては、このリスクは無視できません。

ChatGPTの利便性を最大限に活用しつつ、情報漏えいのリスクを最小限に抑えるためには、入力内容を慎重に検討し、個人・機密情報の入力は避けるべきです。

以下の記事では、ChatGPTのプライバシー保護について解説しています。

バグによってチャット履歴が流出する

ChatGPTのシステムにバグが発生した場合、ユーザーとのチャット履歴が外部に流出してしまう可能性があります。

実際に、2023年3月にはChatGPTのバグによって、ユーザーのチャット履歴、メールアドレス、電話番号が流出しています。OpenAIはこのインシデントにより、ChatGPTの利用を一時停止する措置をとりました。

チャット履歴には個人・機密情報が含まれている場合があるため、流出してはいけない情報はプロンプトに含めない方がよいでしょう。

OpenAIのミスによって情報が漏えいする

OpenAI社のミスによる情報流出も発生しています。2023年3月25日、OpenAIは「ChatGPTにおいて個人情報漏えいが発生した」と公表しました。

有料版のChatGPT Plusに加入しているユーザーの氏名、住所、クレジットカード番号などの情報が漏えいしたのです。

この事例では、ChatGPT Plusユーザーの約1.2%の情報が約10時間にわたり流出したとされています。

OpenAIのサービスであるChatGPTを使ううえで、このようなリスクも考慮しておくべきでしょう。

マルウェアに感染して情報を抜き取られる

ChatGPTのユーザー情報は、マルウェア(ウイルス)の感染によって漏えいするリスクがあります。

Kaspersky(カペルスキー)の調査によると、ダークウェブ上でChatGPTから抜き取られたアカウント情報が掲載されており、これらの情報はサイバー犯罪者に売買されています。とくに、メールアドレスやパスワードが漏えいしたとされています。

原因は、ChatGPT使用者がマルウェアに感染していたためです。

ChatGPTを企業で使う場合は、AIの使い方だけでなく、PCのセキュリティに関する知識も社員に求められることがわかる事例です。

ChatGPTのセキュリティリスクや回避ポイントについては、以下の記事も参考にしてみてください。

関連記事:ChatGPTのセキュリティリスクを徹底解剖!安全に自社へ導入する方法も紹介

外部からの攻撃でGPTsの内容が流出する

ChatGPTを搭載したチャットボットは、外部からの悪意ある攻撃に対して完全に安全とは言えません。とくに注意が必要なのが、プロンプトインジェクション攻撃です。

プロンプトインジェクションとは、ChatGPTに巧妙に細工されたプロンプトを入力し、意図しない動作を引き起こすサイバー攻撃の一種です。

たとえば、事前にプロンプトを入力しておき、特定のタスクに特化させたチャットボットを開発できるGPTsという機能に対し、以下のようにプロンプトインジェクションが可能です。

このような攻撃から企業の情報資産を守るには、ChatGPTを運用するスタッフに対して、プロンプトインジェクションのリスクを周知し、適切な対処方法をトレーニングすることが重要です。

以下の記事ではChatGPTのプロンプトインジェクションについて解説しています。実例や対策を知りたい方はぜひこちらもご覧ください。

アカウント情報が流出する

2025年2月、ChatGPTユーザーのログイン情報を抜き取り、ダークウェブで売買される被害がありました。

Malwarebytesによると、あるユーザーが「2,000万件規模のOpenAIアカウントを一括販売する」と掲示し、実際のサンプルデータも公開したことが確認されています。

流出したアカウントには、過去のチャット履歴が紐づいているため、企業機密や個人情報を閲覧・検索されるリスクがあります。

被害を防ぐためには、定期的なパスワード変更や多段階認証を行うことが重要です。

ChatGPTは無料・有料(Plus)問わず情報漏えいリスクがある

ChatGPTは無料でも有料でも、プロンプトに入力した情報は学習されるうえ、OpenAI側のミスによって情報漏えいが発生するリスクもあります。

また、有料プラン(ChatGPT Plus)に課金するためにクレジットカードを登録する必要があるため、有料ユーザーの方が少しリスクが高いといえるでしょう。

できるだけセキュリティを高めた利用をしたい方は、後半に解説する情報漏えいリスクを抑える方法を実践しましょう。

ChatGPTで情報流出したSamsungの事例

韓国の大手電機メーカーSamsung(サムスン)は、2023年3月に社内でChatGPTの利用を許可しましたが、その後わずか20日間で少なくとも3件の機密情報流出事案が発生しました。

確認された3件は、以下のとおりです。

| 問題点 | 内容 |

|---|---|

| 設備情報の流出 | 半導体設備のソースコードをChatGPTに入力してエラー解消策を問い合わせた |

| 機密情報の流出 | 歩留まりや不良設備を把握するプログラムのソースコードを入力し、最適化を図った |

| 会議内容の流出 | 社内会議の録音データを文書化してChatGPTに入力し、議事録を作成しようとした |

このインシデントを受けて、サムスンはChatGPTの利用を禁止しました。

同様のインシデントが起きないよう、自社に導入する際はこの事例を参考に対策を立てるとよいでしょう。

その他の禁止事例を確認したい方は、以下の記事も参考にしてみてください。

ChatGPTの情報漏えいリスクを抑える7の対策

ChatGPTの情報漏えいリスクを抑える方法は、以下の7つです。

- 個人情報や機密情報を入力しない

- 社内ガイドラインを作成する

- OpenAI APIを利用する

- Microsoft Azureで自社専用のチャットボットを開発する

- 入力データを学習させない設定にする

- ビジネスプラン・エンタープライズプランを利用する

- 社員教育に力をいれる

それぞれの対策について、詳しくみてみましょう。

個人情報や機密情報を入力しない

ChatGPTを安全に活用するためには、個人情報や機密情報をChatGPTに入力しないことが重要です。

ChatGPTに入力されたデータは、将来的にモデルの一部となる可能性があります。つまり、ChatGPTに企業の機密情報を入力すると、その情報がモデルに取り込まれ、他のユーザーとの対話で意図せず漏えいするリスクがあるのです。

したがって、ChatGPTを利用する際は、入力内容を慎重に吟味し、個人情報や機密情報の共有は控える必要があります。機密性の高いデータを扱う企業にとって、この点はとくに重要な留意事項です。

社内ガイドラインを作成する

ChatGPTの利用に伴う情報漏えいリスクを抑えるためには、社内でのChatGPT利用に関するガイドラインを作成し、従業員に周知することが効果的です。

ガイドラインには、ChatGPTの利用目的や利用範囲、禁止事項などを明記し、情報漏えいにつながる行為を防止します。

以下は、社内ガイドラインに含めるべき主な項目です。

| 項目 | 説明 |

|---|---|

| 利用目的 | 業務上のどのような目的でChatGPTを利用するかを明確にし、業務に直接関係のない利用は制限する |

| 利用範囲 | ChatGPTを利用できる従業員の範囲を限定し、必要最小限の情報にアクセスできるよう設定する |

| 禁止事項 | 個人情報や機密情報をChatGPTに入力することを禁止し、違反した場合の罰則を設ける |

| セキュリティ設定 | ChatGPTのアカウント管理やアクセス制御に関する規定を設け、不正アクセスを防止する |

| モニタリング | ChatGPTの利用状況を定期的にモニタリングし、不適切な利用がないか確認する |

| 教育・研修 | 従業員にガイドラインの内容を周知し、情報セキュリティに関する教育・研修を実施する |

社内ガイドラインを作成し、正しく運用することで、従業員のChatGPT利用に関する意識を高め、情報漏えいのリスクを減らせるでしょう。

OpenAI APIを利用する

OpenAI API※を利用することで、自社のシステムにChatGPTの機能を組み込み、より安全に活用できるようになります。

※互換性のないソフト同士で機能を利用できるようにする仕組み

APIを介してChatGPTにアクセスすることで、以下のようなメリットがあります。

- 自社のセキュリティポリシーに沿ったアクセス制御が可能

- 入力データや出力結果を自社のサーバーで管理できる

- 利用状況のログを取得し、監査やモニタリングに活用できる

OpenAI APIを利用することで、ChatGPTの利便性を享受しつつ、情報漏えいのリスクを抑えられます。

ただし、APIの利用には一定のコストがかかるため、予算や人的リソースを考慮した上で導入を検討しましょう。

Microsoft Azureで自社専用のチャットボットを開発する

Microsoft AzureのCognitive Servicesを活用し、自社専用のチャットボットを開発することで、ChatGPTの情報漏えいリスクを大幅に軽減できます。

Azureのチャットボットは、自社環境で運用するため、機密情報が外部に送信される心配がありません。

また、Azure Bot Serviceを利用すれば、プログラミングの知識がなくても、簡単に高機能なチャットボットを構築できます。

Azureのセキュリティ機能と連携することで、チャットボットへの不正アクセスやデータ漏えいを防止できるでしょう。

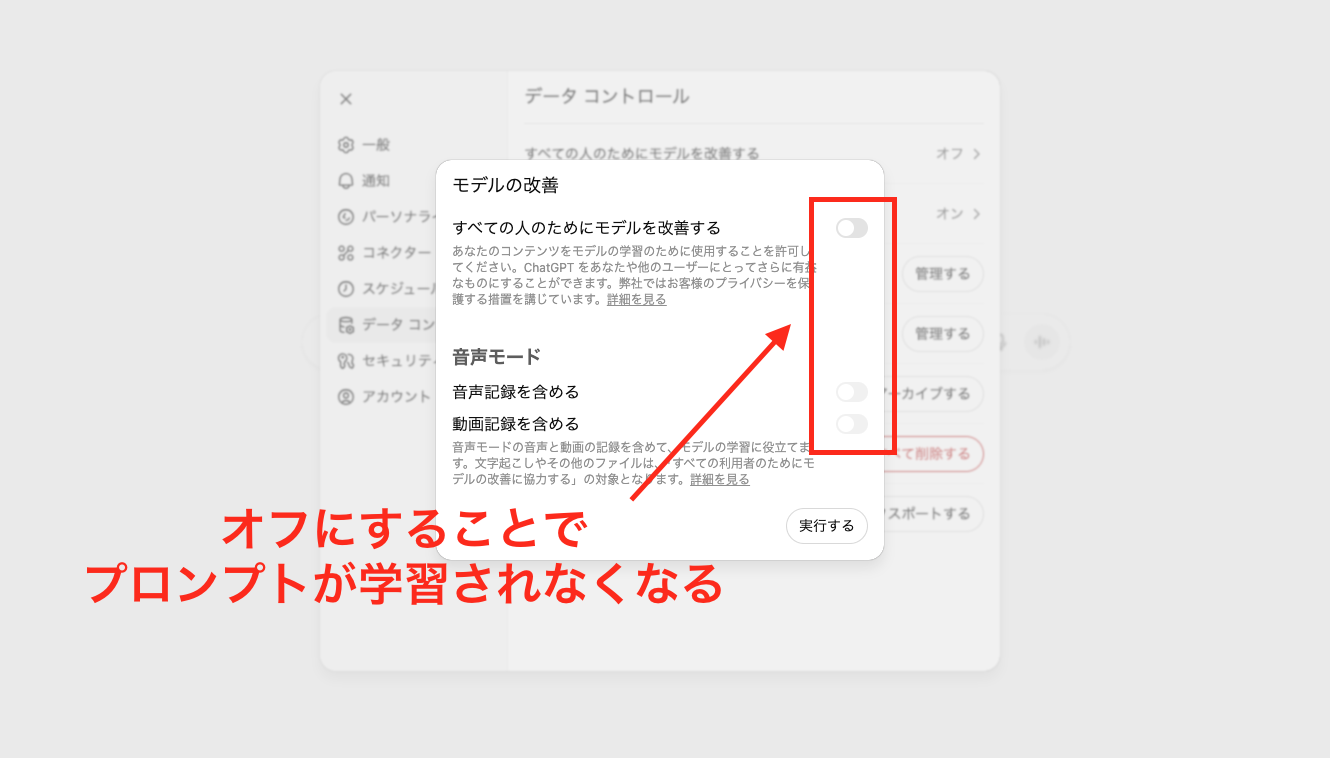

入力データを学習させない設定にする

ChatGPTには、入力したデータを学習させないようにできる2つのオプトアウト機能があります。

それぞれの設定方法は、以下のとおりです。

- 設定画面からチャット履歴をOFFにする:「設定」→「データコントロール」→「すべての人のためにモデルを改善する」をオフにする

- オプトアウト申請フォームから申請する:OpenAI Privacy Request Portalで「Make a Privacy Request」をクリックし、必要情報を入力して申請する

企業がChatGPTを業務で利用する際は、機密情報の漏えいを防ぐために、このオプトアウト機能を活用することが重要です。

ビジネスプラン・エンタープライズプランを利用する

ChatGPTには、セキュリティが強化された「ChatGPT Business」※と「ChatGPT Enterprise」という2つのプランが用意されています。

※「ChatGPT Team」から名称変更

Businessプランは中小企業やプロジェクトチームなど、比較的小規模な組織での利用に適したプランです。一方、Enterpriseは大企業向けのプランで、より大規模な組織での利用に適しています。

2025年8月8日には、最新モデルの「GPT-5」がリリースされました。全てのモデルがGPT-5に自動移行されましたが、有料プランのユーザーはGPT-4、o3などの以前のモデル(レガシーモデル)も利用できます。

2025年9月23日時点での、それぞれのプランの特徴を表にまとめます。

| 比較項目 | ChatGPT Business | ChatGPT Enterprise |

|---|---|---|

| 料金体系(税込) | 月額25ドル/ユーザー(年払い) 月額30ドル/ユーザー(月払い) | 企業規模に応じて変動 |

| 言語モデル | GPT-5 GPT-5 Thinking GPT-5 Pro GPT-4o GPT-4.1 OpenAI o3 OpenAI o4-mini | ChatGPT Businessと同様 GPT-4.5 OpenAI o3 pro |

| メッセージ数※ | 無制限 | 無制限 |

| 生成速度 | 高速 | 最高速度 |

| 入力トークン数※ | 32K | 128K |

| セキュリティ | 高い | 非常に高い |

| 管理機能 | あり | あり |

上記のプランでは、入力された情報がChatGPTの学習に使用されることはありません。

企業がChatGPTを業務に活用する場合、2つのプランを状況に応じて使いわけることが重要です。たとえば、社内の特定部署や少人数のプロジェクトチームでの利用であればBusinessプランで十分でしょう。

一方、全社的な導入を検討している大企業の場合は、大規模な利用に最適化されたEnterpriseが適しています。

詳しくは、OpenAI公式サイトから確認してみてください。

社員教育に力をいれる

ChatGPTなどのAIツールを適切かつ効果的に活用するためには、社員のAIリテラシーを高めることが重要です。

AIリテラシーとは、AIの基本的な仕組みや特性を理解し、AIを適材適所で活用しながら、その限界も踏まえて適切に付き合っていく力のことを指します。

たとえば、以下のような知識・スキルが求められます。

- 生成AIの基礎知識

- 生成AIが得意なこと・苦手なこと

- 情報漏えいや著作権のリスク

- プロンプトを作るスキル

AIツールを適切かつ効果的に活用するためには、社員のAIリテラシーを高めることが重要です。

「質の高いプロンプトでAIの能力をもっと引き出したい」「プロンプトのコツを知りたい」という方に向けて、この記事では「【超時短】プロンプト150選」を用意しています。

この資料ではジャンル別に150個のプロンプトを紹介しています。また、プロンプトエンジニアリングのコツも紹介しており、実践的な資料が欲しい方にも適しています。

無料で受け取れますが、期間限定で予告なく配布を終了することがありますので、今のうちに受け取ってプロンプトをマスターしましょう!

30秒で簡単受取!

無料で今すぐもらうChatGPTの情報漏えいリスクに備えた各国の動き

ChatGPTのリスクに対して、世界各国では生成AIの学習データに関する規制や、生成AIそのものの利用に関する規制が進められています。

たとえば、EUでは個人のプライバシー保護と個人データの不適切な利用防止を目的とした「EU一般データ保護規則(GDPR)」が存在します。

2023年3月、イタリアではChatGPTがGDPRに違反しているとして一時的に利用を禁止しましたが、OpenAIが改善策を導入したことで現在は利用が許可されています。

一方、安全保障や社会の安定への影響を懸念し、中国ではChatGPTの利用が現在も禁止されています。

このように、各国における生成AIに対する規制や対応はさまざまです。

| 地域・国 | 規則・法律・取組 | 概要 |

|---|---|---|

| EU | AI規則案 | EUにおけるAIの活用・開発やAIへの投資を強化するとともに、人々と企業の安全と基本的権利を保護することが目的 |

| AI法 | AIの開発・運用に関する包括的な規則を定めた規則 | |

| 米国 | AI権利章典のための青写真 | AI開発にあたって考慮すべき原則をまとめた白書 |

| 人工知能リスク管理フレームワーク | AIの開発・販売に関するフレームワーク | |

| 中国 | 生成人工知能サービス管理弁 | 生成AIを使用した製品・サービスに関する法律 |

| 日本 | 各種ガイドラインの作成 | AI開発ガイドライン、人間中心のAI社会原則、生成AIと著作権の考え方などのガイドラインを作成 |

| 広島AIプロセス | G7サミットで行われた、生成AIの利活用に関する議論をするための国際プロジェクト |

生成AIに関する国際的な議論やルール作りは、今後も活発に行われると予想されます。

とくに、生成AIをビジネスで利用している、または利用を検討している場合は、生成AIに関する法規制や動向に注意を払うことが重要です。

無料でも利用可能なChatGPTの機能や使い方については、以下の記事で詳しく解説しています。

【無料で使える】ChatGPT-4(GPT-4o)の特徴や活用事例、使い方を完全網羅!

GPT-4(GPT-4o)は文章・画像・音声に対応の、回答の正確性や多様な機能が特徴のAIモデルです。本記事では、GPT-4oの基礎知識や機能、活用方法などを解説します。本記事を読めば、ChatGPTで業務効率化を一気に進められるでしょう。

ChatGPTの情報漏えいリスクを考慮した運用を検討しよう

ChatGPTを使ううえで、情報漏えいリスクは避けて通れません。

しかし、本記事で紹介した対策を行えば、リスクは低減できます。

企業の場合、リスク対策の中でもっとも重要なのが「社員教育」です。企業側がセキュリティ対策を万全に行っても、使用する社員がリスクを理解していなければリスクは高いままです。

ChatGPTの情報漏えいリスクを理解し、自社に合った適切な対策を講じてChatGPTを安全に活用しましょう。

「質の高いプロンプトでAIの能力をもっと引き出したい」「プロンプトのコツを知りたい」という方に向けて、この記事では「【超時短】プロンプト150選」を用意しています。

この資料ではジャンル別に150個のプロンプトを紹介しています。また、プロンプトエンジニアリングのコツも紹介しており、実践的な資料が欲しい方にも適しています。

無料で受け取れますが、期間限定で予告なく配布を終了することがありますので、今のうちに受け取ってプロンプトをマスターしましょう!

30秒で簡単受取!

無料で今すぐもらう執筆者

SHIFT AI TIMES編集長/著者

大城一輝

SEO記事やAI関連書籍のライターやSEOマーケター、AIコンサルタントとして活動している。AI活用の講師やAIメディアの監修も多数経験。

SHIFT AIではオウンドメディア(SHIFT AI TIMES)の編集長を担当。また、SHIFT AIのモデレーターとしてAI系セミナー登壇経験多数。

著書は「はじめての生成AI Microsoft Copilot「超」活用術」。その他、AI系書籍の監修にも携わる。

G検定・生成AIパスポート・Generative AI Test合格(その他、簿記3級、FP3級など取得)・Google AI Essentials修了

ノーコード生成AIツール「Anything(旧Create)」公式アンバサダー

Xはこちら、LinkedInはこちら

30秒で簡単受取!

無料で今すぐもらう