GPT-5のその先。今後数年で性能が飛躍すると予想される根拠。【bioshok file 002】

執筆者

AI安全・AIトレンド 啓発アナリスト(独立)

bioshok

大学では半導体に関する研究をし、大学院では自然言語処理に関する研究を行う。 現在はITエンジニアとして働く。 Xの@bioshok3(フォロワー数2万9千人)にてAIに関するトレンドとAIのリスクに関わる多数の情報発信を行っている。著書に “AIのもたらす深刻なリスクとその歴史的背景” (2024)や人工知能学会の私のブックマークに”AIアライメント”がある。超知能がある未来社会シナリオコンテスト(2024)にて「(ファイ)の正夢」(共著)にて佳作を受賞。

2025年は各社がAIフロンティアモデルのメジャーアップデートを行いました。

例として、OpenAIが8月と11月にGPT-5とGPT-5.1を発表し、GoogleDeepMindがGemini 3 Proを11月に発表。

その一方で各社AIインフラへの多額の投資が相次ぎ、AIはバブルなのではないか、これ以上AIの進歩が起こるのかという疑念も巻き起こっているように思えます。

今回の記事では「今後数年から5年は、AIの性能は引き続き飛躍し続ける可能性が高い」という点をGPT-5の考察から解説します。

SHIFT AIでは、ChatGPTやGeminiなどの生成AIを活用して、副業で収入を得たり、昇進・転職などに役立つスキルを学んだりするためのセミナーを開催しています。

また、参加者限定で、「初心者が使うべきAIツール20選」や「AI副業案件集」「ChatGPTの教科書」など全12個の資料を無料で配布しています。

「これからAIを学びたい」「AIを使って本業・副業を効率化したい」という方は、ぜひセミナーに参加してみてください。

目次

GPT-5の性能は期待外れ?

2025年12月現在の最新モデルは「GPT-5.1」ですが、それまでの最新モデルだった「GPT-4」シリーズの進化系である「GPT-5」は、さまざまな期待を背負っていました。

OpenAIは2025年8月8日に「GPT-5」をリリース。「GPT-4」のリリースから2年強が経過していたこともあり、その性能ともたらす新たな用途に、世間の期待が高まる中での発表です。

「Situational Awareness」や「AI 2027」といったエッセイやレポートでも「GPT-5」の発表に期待がされていました。

人間のできる認知タスクならほとんどコストパフォーマンスよく実行可能なAIシステム、すなわち「AGIが近いのではないか?」としています。

GPT-5の性能調査の結果

その矢先にリリースされたGPT-5は、一見すると2024年12月に発表されたo3からの大きな性能飛躍を感じづらい成果でした。

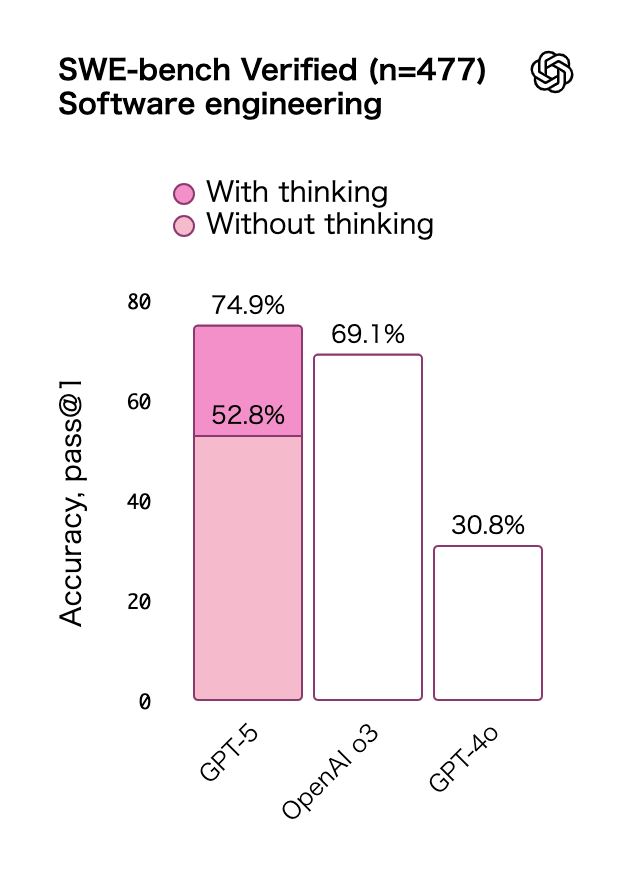

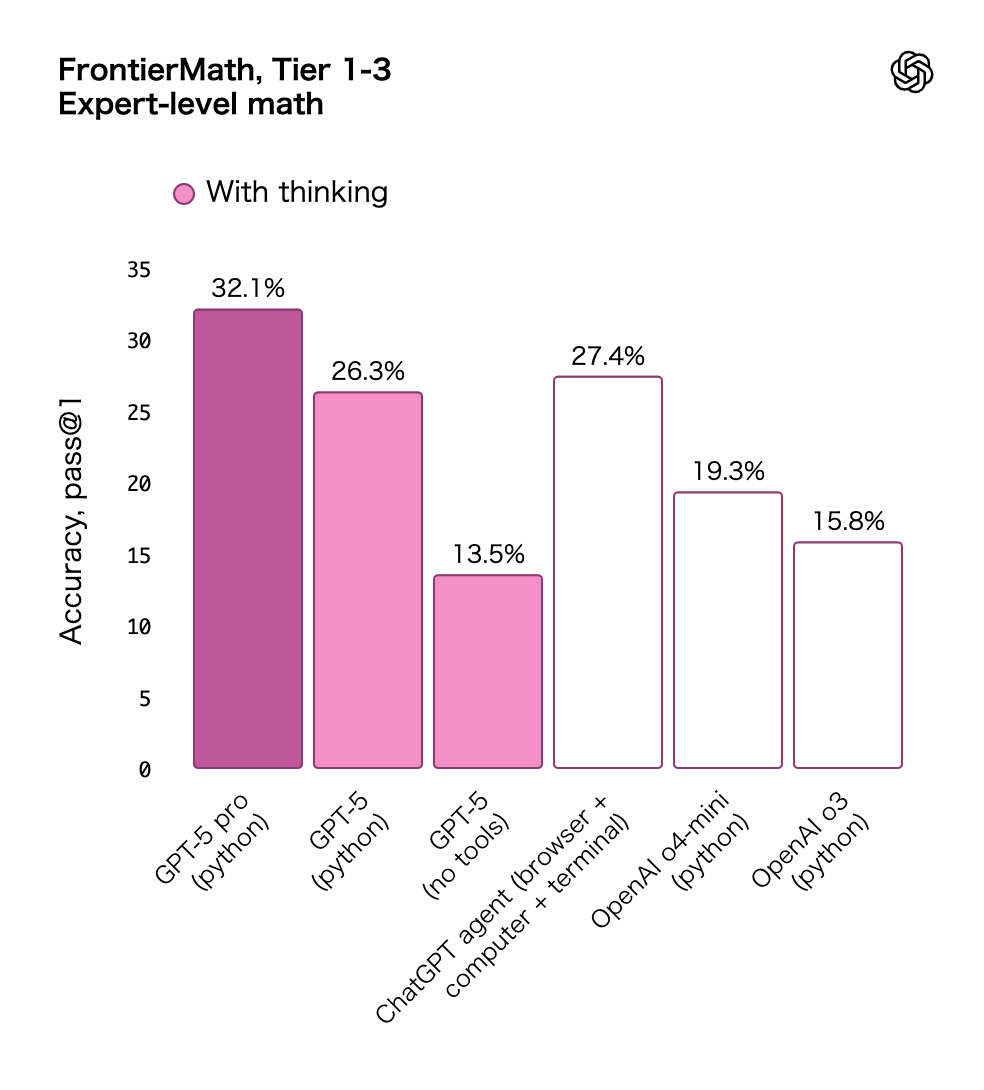

グラフからは以下のように読み取れます。

- SWE-bench Verified:69.1%→74.9%(OpenAI o3→GPT-5)

- FrontierMath:19.3%→26.3%(o4-mini(python)→GPT-5(python))

- SWE-bench Verified:ソフトウェアエンジニアリングに関するベンチマーク

- FrontierMath:数学者にとっても難しい問題を集めている

確かに進歩ではありますが、漸進的なもので、大きな飛躍とは感じにくいでしょう。

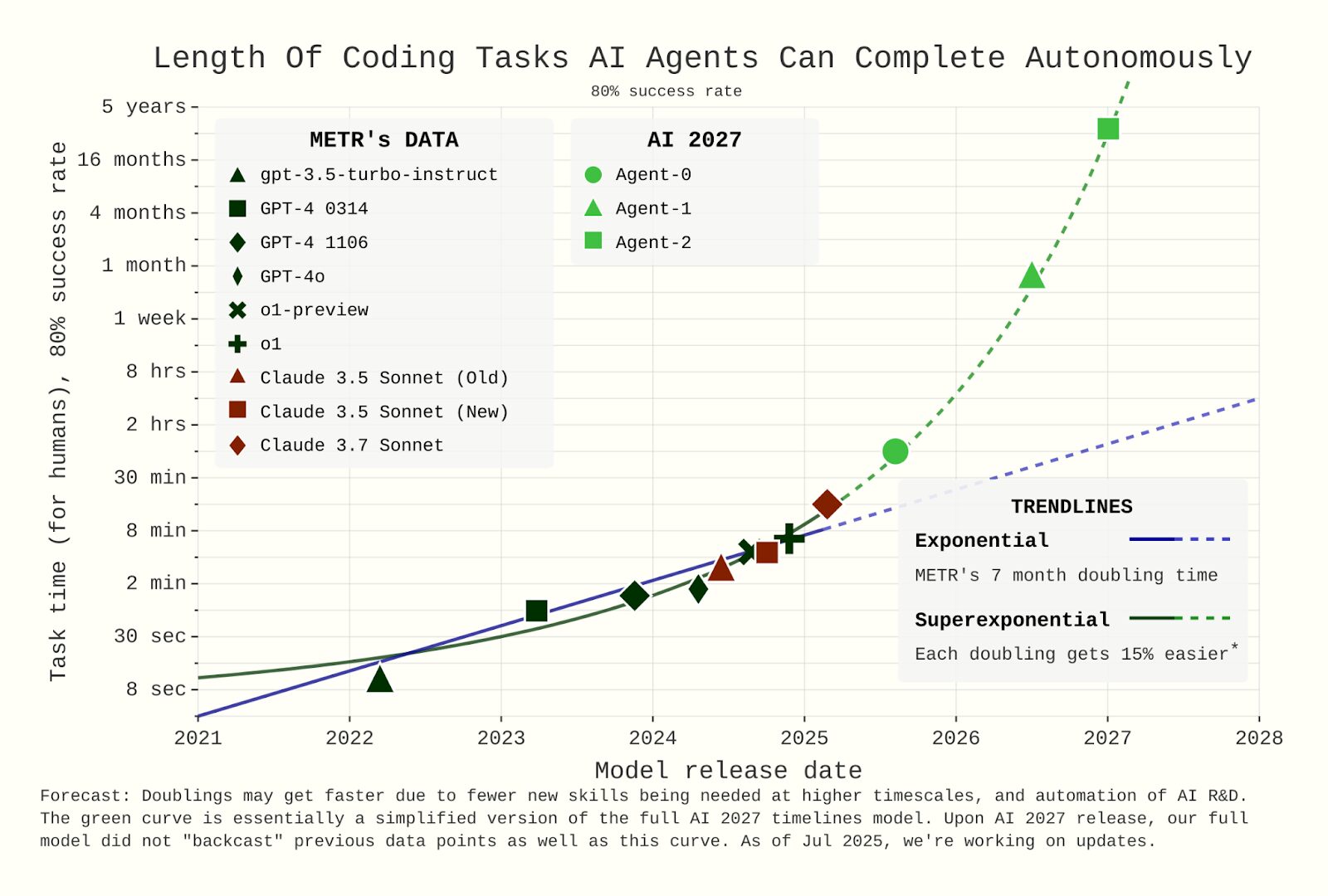

またエージェント能力、自律性のベンチマーク面においても、ある意味期待はずれなものでした。

AI2027による言及とGPT-5の自律性の結果

AI2027(2027年末までにAGIが開発される可能性があるとするレポート)では、以下のように言及されています。

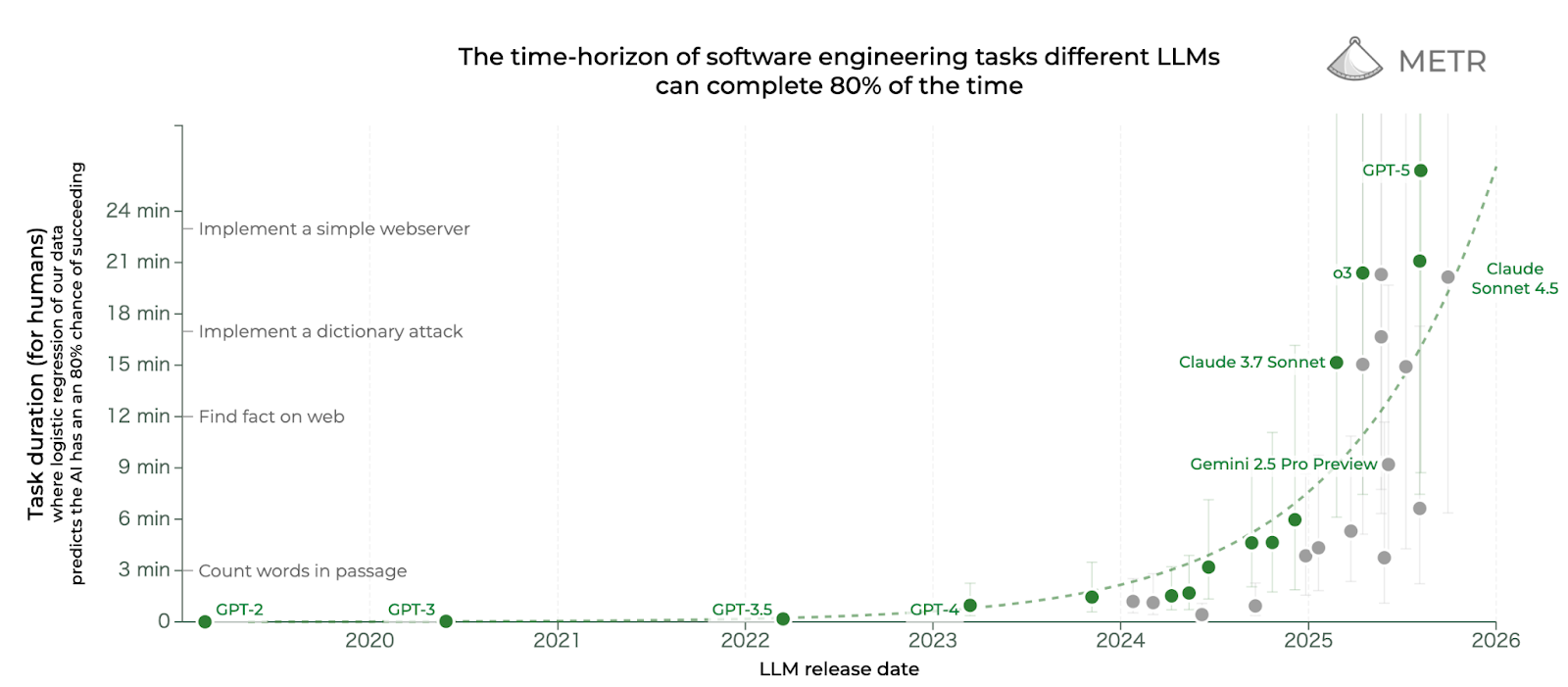

”2025年に出てくる「Agent0」と呼ばれるAIは、METRのソフトウェアエンジニアリングに関する自律性のベンチマークではおよそ「1時間のタスクを80%の確率でこなせる」レベルになっている”

しかし「GPT-5」は、人間なら26分でできるタスクを「自律的に80%の確率で完了する」という結果に。

AI2027が予想した1時間よりも短いタスクしか現状行えていません。このギャップは、以下のグラフからも読み解くことができます。

確かに「GPT-5」は、ハルシネーションが減少していたり、コストが安くなりました。

自動ルーティング機能がつき、週間アクティブユーザー7億人が推論モデルを使用できるようになったインパクトは大きいでしょう。

「GPT-5」は純粋な性能向上を目標にしておらず、多くの人にAIの価値を感じさせ、巨大な消費者市場を視野に入れているというSemianalysisの考察もあります。

一方で純粋な性能向上という面ではインパクトを感じずらかった人も多かったのではないでしょうか。

ここで、一つの疑問が湧いてきます。

GPT-5リリースは、「OpenAIが基本路線とする計算資源のスケーリングによる“AI性能の向上のトレンドから外れたイベント”」だったのでしょうか?

GPT-5はGPT-4から殆どスケールアップされていない

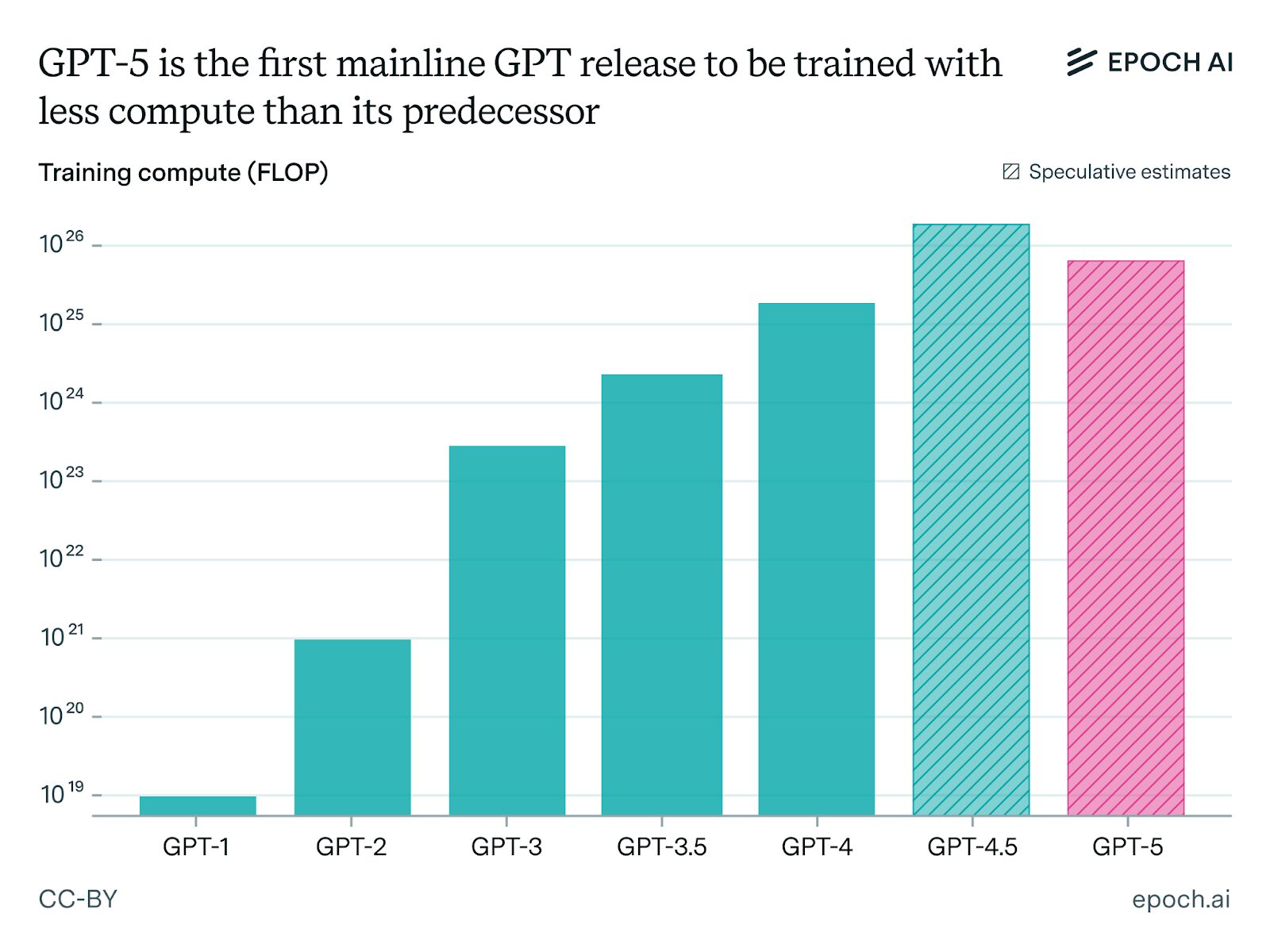

AIトレンドを緻密に分析しているEpochAIは、「GPT-5」は「GPT-4」からスケールアップした計算資源で学習されておらず「GPT-4.5」にさえ至らない計算量で訓練されたと示唆しています。

※OpenAIから2025年11月にリリースされたGPT5.1については、ナンバリングが0.1上がっただけのため、GPT-5から殆ど学習計算量はスケールアップされていないと想定されます。

彼らの分析によると、「GPT-5」は事前学習と事後学習を合わせて「5×10^25FLOPs」の計算量でトレーニングされた可能性が高く、事後学習は「10^24FLOPs台」の可能性もあります。

参照:X(EpochAI)

参照:X(EpochAI)

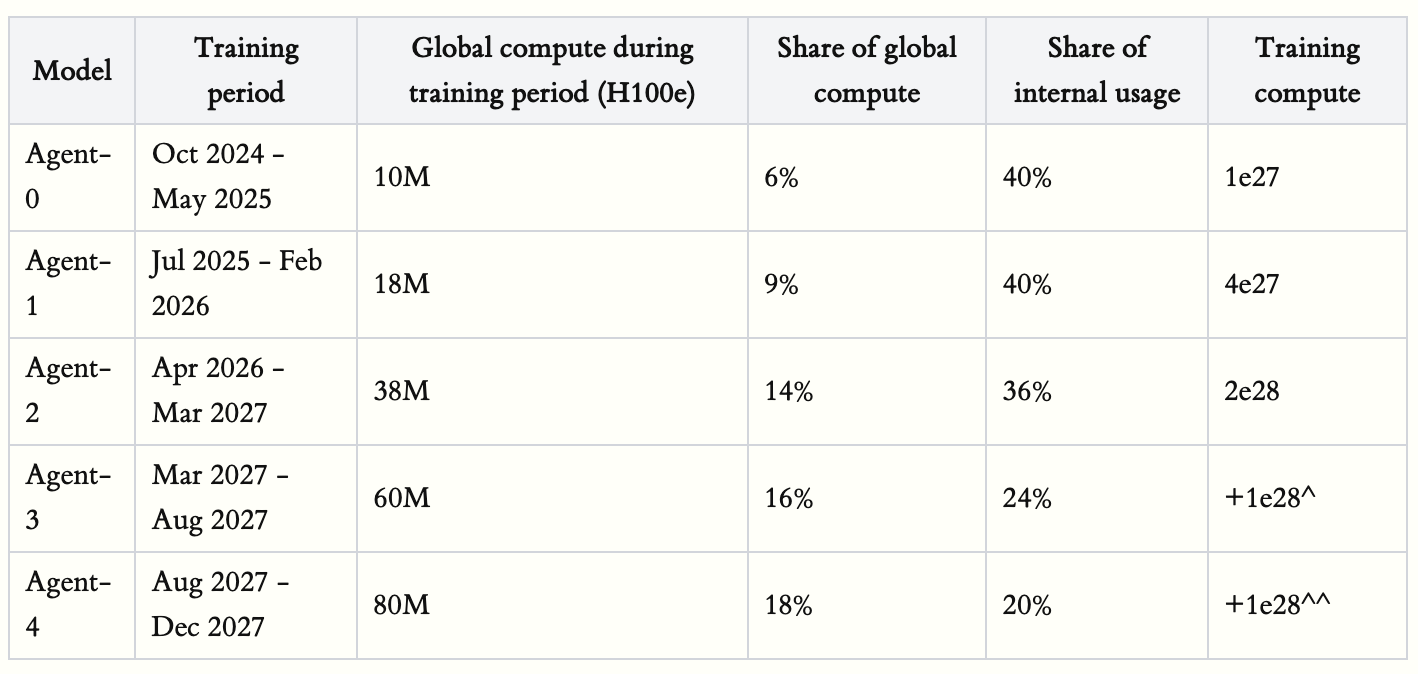

一方で、AI2027レポートで2025年にリリースされる予想であった「Agent-0モデル」の計算量はおよそ「10^27FLOPs」となり、20倍以上も異なるのです。

参照:AI2027

これら分析を総合すると、当初予想されていたトレンドは、少なくとも「10^27FLOPs」の計算量でトレーニングされたモデルが「GPT-5」としてリリースされる、であると予想できます。

一方で、現実には「10^25FLOPs台」の計算量でトレーニングされたモデルが「GPT-5」としてリリースされたことになります。

「GPT-5」の“微妙な性能向上”が意味するのは、スケーリングが頭打ちになったのではなく、スケーリングがそもそも「GPT-4」からそこまで行われていないということでしょう。

つまり、今後学習のスケーリングを行う余地は、まだまだ残されているということです。

なぜOpenAIはスケーリングを行わなかったのかには諸説ありますが、EpochAIは以下のように分析しています。

“最も大きいのはLLMを強化学習でスケーリングするパラダイムは始まったばかりであり、学習環境を整える試行錯誤や報酬ハッキングを防ぐAI安全性観点からの試みで当初想定よりは遅れている”

これはスケーリングをするための準備期間が予定より長引いていることを意味すると思われます。

強化学習のパラダイムは始まったばかり

少し遡ると、2024年9月にOpenAIが「o1」をリリースしてから、推論モデルの時代が始まりました。

「GPT-1」から「GPT-4.5」まで、今までは基本的に「より大きなモデルと、より大きなデータを事前学習するパラダイム」が主流でした。

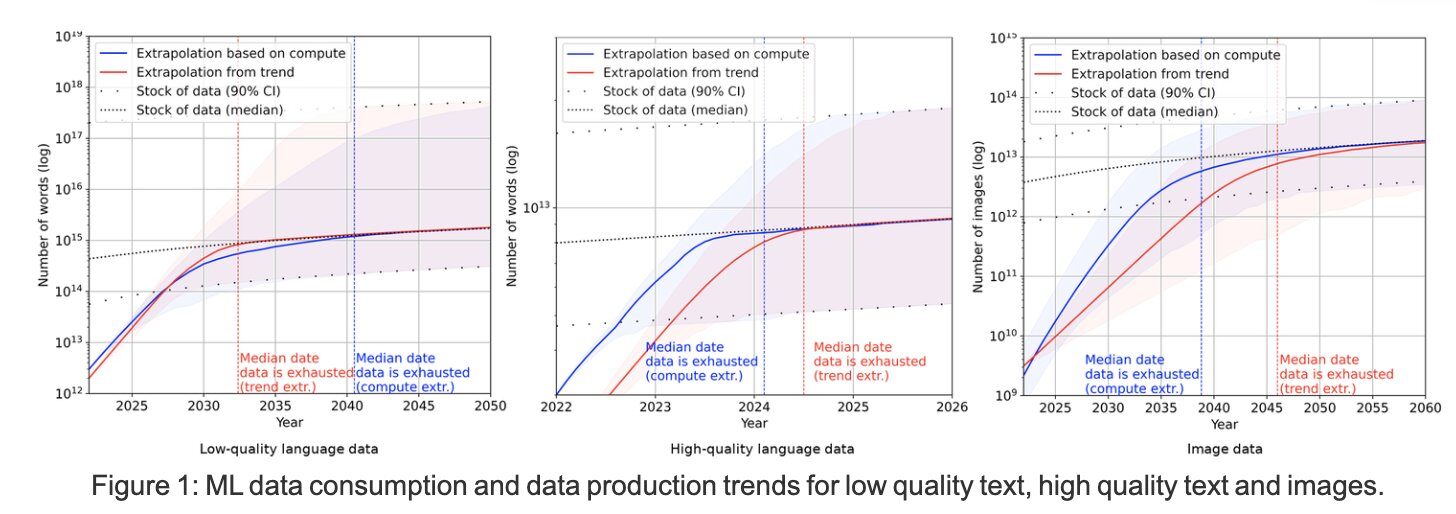

しかし数年前の時点で、主にテキストデータの枯渇※により、「このままだとスケーリングに必要なデータが不足する」という予想もありました。

※諸説ありますが、マルチモーダルデータに関しては、実は余裕があるとされています。

そこで、スケーリングの継続のために新たに出てきた手法が推論モデルのパラダイムとなります。

- ある問題に対してより長く生成するトークンを費やす

- 何らかの正誤判定で報酬を与え強化学習を実行する

- よりモデルの性能を引き出すことが可能になった

事前学習したベースモデルを用いて強化学習を行うため、このフェーズを事後学習といいます。

この事後学習のパラダイムはまだ始まったばかりです。

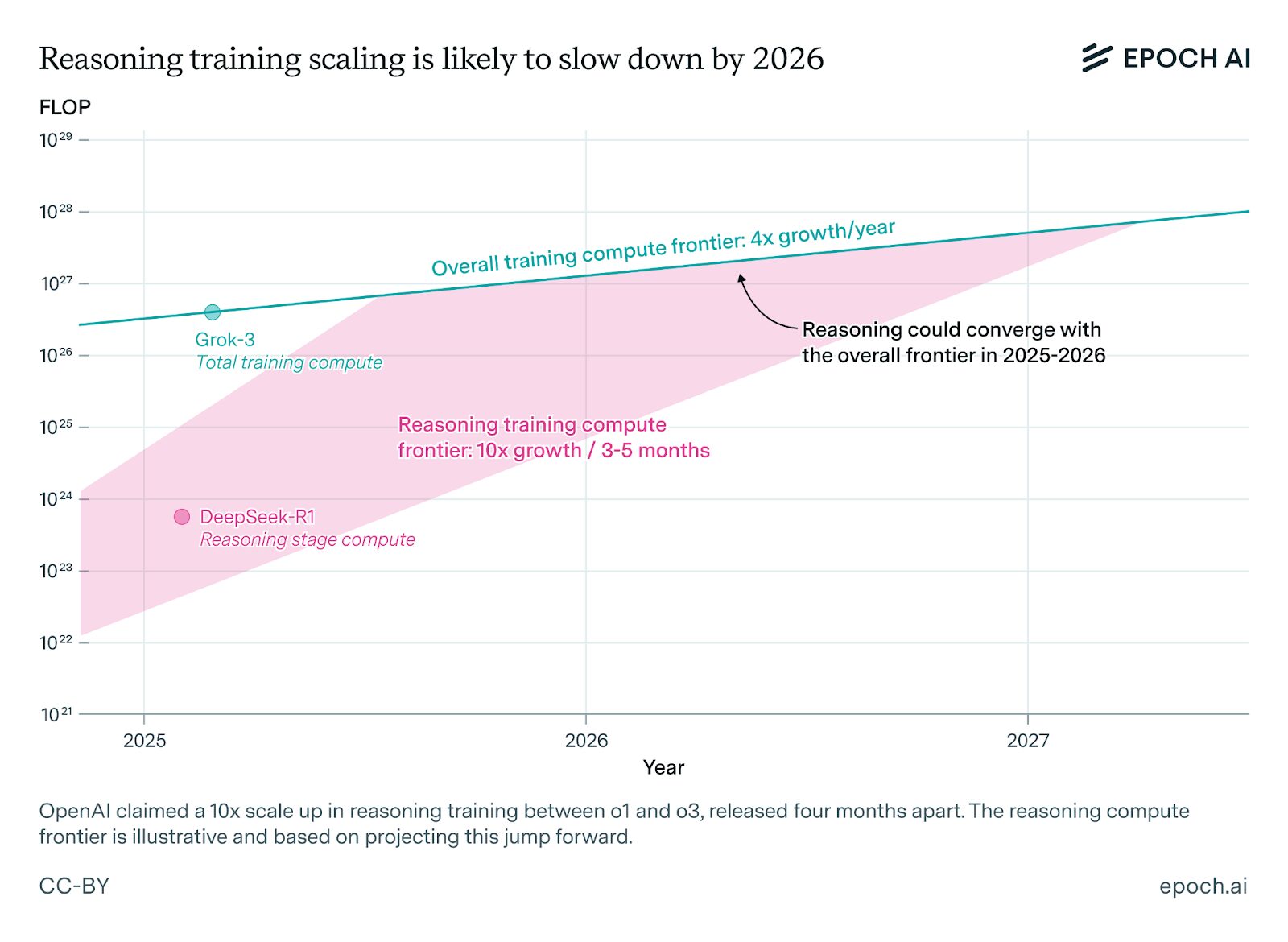

例えば、直近のOpenAIがリリースしたモデルは、以下の規模で事後学習で訓練された可能性が高いと考えられます。

- o1:10^23FLOPs台

- o3:10^24FLOPs台

- GPT-5:10^24~25FLOPs台

そして、事後学習に費やせるOpenAIのようなフロンティアAI研究機関の計算量は今年だけで2×10^27FLOPsあり、2027年末までに2×10^28FLOPsと考えられます。

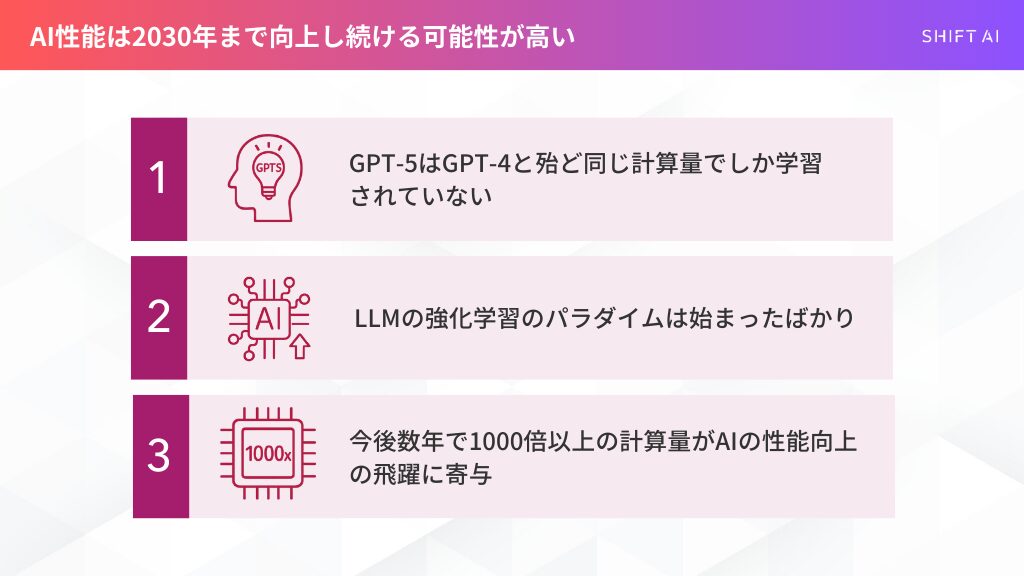

現在事後学習に「2×10^25FLOPs」しか費やされていないと仮定すると、「今年だけで100倍、27年末までには1000倍のスケールアップが可能な余地が残されている」と言えるのです。

補足ですが、GoogleDeepMindが2025年11月に発表した「Gemini 3 Pro」については、事前学習の革新が大きな性能向上の飛躍を牽引したとされています。

つまり、事後学習については「GPT-」5と殆ど同じ程度の計算資源しか使っていない可能性が高いと思われます。

故に、今後数年は事後学習のスケーリングによる大きなアップサイドが期待されるでしょう。

OpenAIも今後事前学習の革新を大きく推し進めながら事後学習も大きく進めていくと考えられます。

2027年末までのAGIの蓋然性

「o1」から「o3」が10倍のスケールアップとすると、1000倍のスケールアップは単純計算で「o6」にまで至ることになります。

今回のGoogleDeepMindによるGemini 3 Proの事前学習の革新のように「アーキテクチャの改善も年間3倍ある」と仮定した場合。

実効的には「2027年末までに更に10倍のスケールアップと同等の効果」が見込まれる可能性があります。

その場合、2027年末までに、実効的には1万倍のスケールアップが可能※となるのです。

※oシリーズのナンバリングが1つ上がることで10倍になると仮定した場合の、「o1」から「o7」までの変化の推測です。

それほどの性能向上が起こった先に、「人間の行うほとんどの経済的に価値のあるタスクを実行可能なAIシステム」、いわゆるAGIが実現する可能性もあるでしょう。

実際にAnthropicやOpenAIのGreg Brockman氏は数年以内の実質的なAGIと言えるようなAIシステムの開発に強気です。

AGIはLLMの延長で達成できる可能性

ここ最近LLM(Transformer型モデル)がソロモノフ帰納(SI)※に漸近し得るとする理論研究が同時多発的に発表。

スケーリング競争の延長上にAGIの姿が見えつつあります。

※過去の出来事から未来を完璧に予測するための、究極の計算理論です。 「すべてのつじつまが合う中で、一番シンプルな法則こそが正解」という考え方を使って答えを導き出します。

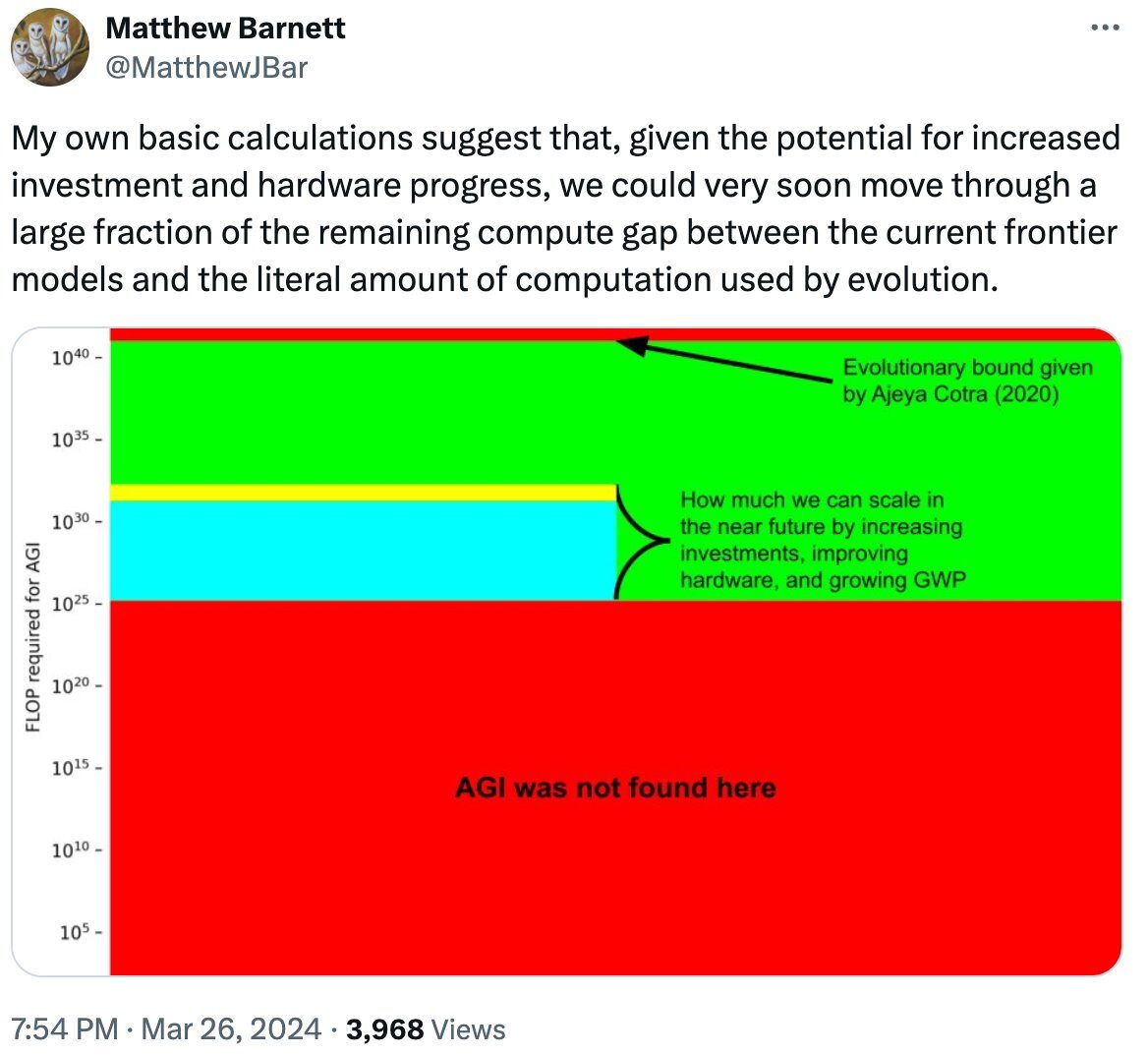

もし、「質的な非連続的な新しい革新がAGI達成に必要ない」のであれば、「どの程度計算資源を量的に拡大すればAGIが開発されるのか」を考える必要が出てきます。

OpenPhilanthrophy(アメリカの慈善団体)は、早期からAGIに相当するような革新的なAI(Transformative)が実現する時期を計算量の観点で予想。以下の言及をしています。

参照:LESSWRONG

- AIモデルの学習に費やす計算量を増やすほど革新的なAIが実現する可能性が高いと予想

- その妥当な上限として、地球生命史を全て計算でシミュレーションするために必要な計算量を仮定

その結果は、以下のポストでもわかりやすく示されているように、「GPT-5」の計算量スケールで実現されたモデルまででは、AGIは見つからないという結論でした。

一方でこの投稿は、以下の内容を視覚的に示しています。

- 「2030年までに投入される実効計算量」と「残りの進化的な計算量の上限までの残り計算量」を対数的なスケールで考える

- 今後5年以内にAGIが実現する蓋然性も高いと考えられる

EpochAIによると、直近では2030年まで時間スケールを伸ばせば、計算資源は少なくとも「2*10^29FLOPs」使用できる可能性が高いとされています。

さらにアーキテクチャの改善も2年分上乗せすれば、100万倍の実効的なスケールアップが2030年までに行われる可能性が高くなります。

まとめ:2030年までAIの性能向上は続く可能性が高い

「科学研究を含む多くの業務を相当程度支援可能なAIシステム」が誕生している蓋然性は高いとされています。

2027年または2030年末までに、人間の行う認知タスクのほとんど全てを実行可能なAIシステムが存在しなかったとしても……です。

一方2030年以降で、一つのAIモデルのトレーニングに費やす費用が1兆ドルを超え、アメリカのGWPの3~4%を占めてくる場合。

実際にAIが経済的に有用なことが示され続けない限り、スケーリングが鈍化すると想定されています。

いずれにしても、今後数年から5年以内にAIの進歩が止まる蓋然性は低いと考えられます。

今後2030年までの目先のトレンドを見れば、「おおよそAIの性能は高まっていくし、2027年末までには今までの性能向上のトレンドよりも大きな飛躍が見られる可能性が高い」と考えられます。

そのため、AIの進歩を過小評価せず、様々なシナリオに我々は備えておく必要があるでしょう。

もし本当にAGIが今後近いうちに達成された場合、以下のような可能性を考慮に入れる必要があります。

- AIの性能が固定計算資源の元でも飛躍的に高まる可能性(知能爆発)

- 数百年の技術進歩が10年程度で達成される可能性(技術爆発)

- カルダシェフスケール文明への数十年での飛躍といった短期間での産業や経済の急成長の可能性(産業爆発)

上記のことを考えると、突如として人類史上でも最も大きいと言えるような変化が社会を覆うため、など今から議論していかなければなりません。

- 軍拡競争の高まり

- AIの制御の不可能性

- 悪用による甚大な被害

- 人類が徐々にAIに依存するリスク

SHIFT AIでは、ChatGPTやGeminiなどの生成AIを活用して、副業で収入を得たり、昇進・転職などに役立つスキルを学んだりするためのセミナーを開催しています。

また、参加者限定で、「初心者が使うべきAIツール20選」や「AI副業案件集」「ChatGPTの教科書」など全12個の資料を無料で配布しています。

「これからAIを学びたい」「AIを使って本業・副業を効率化したい」という方は、ぜひセミナーに参加してみてください。

スキルゼロから始められる!

無料AIセミナーに参加する

スキルゼロから始められる!

無料AIセミナーに参加する