AGI実現、2030年までに75%超?専門家が語る存亡リスクと打開策

「AI」と聞くと、どこか難解で敷居の高いものだと感じる方も少なくないでしょう。けれども実際には、AIはすでに私たちの日常に深く入り込み、大きな役割を果たしています。

今回取り上げるのは、いま改めて注目を集めている「AGI(Artificial General Intelligence:汎用人工知能)」。

AGIやAIアライメントについて積極的に発信している著名なAIインフルエンサー・bioshokさんに、率直な問いを投げかけました。

「ずばり、AGIはいつ実現するのでしょうか?」

本稿では、bioshokさんに、AGIをめぐる多様な疑問やAIアライメントの現状、そして進化したAIが人類を滅ぼす可能性──いわゆる「存亡リスク」についてお話を伺います。

目次

迫るAGI時代。2030年までに実現する確率は50〜75%

──AGIやAIアライメントについて研究や情報発信を始めたきっかけを教えてください。

bioshokさん(以下、bioshok):もともとSF小説を読むのが好きで、人類の未来予測に強い関心がありました。

当時はAGIの実現は2100年頃、はるか先の未来だと考えていたのです。ところが2022年前半、プロンプトを工夫するだけで大規模言語モデルの回答性能が大幅に向上するという論文(※1)が発表されました。

さらに同年11月にはChatGPTが公開され、私の考えは一変。AIの進化は想像以上に速く進んでおり、AGIの実現やAIによる人類滅亡の可能性を「遠い未来」ではなく「近未来の現実」として捉えるようになったのです。

(※1)2022年5月に発表された論文「大規模言語モデルはゼロショット推論者」は、プロンプトに「ステップバイステップで考えよう」と加えるだけで、大規模言語モデルの回答性能が向上することを示しました。

──ずばり、AGIはいつ実現すると予想していますか。

bioshok:AGIの実現確率は、2030年末までに50~75%、2027年までに25~50%と見ています。

そう予測する理由の一つは、2027年までにAIに投入される計算資源が現在の約1,000倍に増加すると見込まれているからです。すでに巨大なGPUセンターの建設(※2)も始まっています。

(※2)たとえばOpenAIとOracleは、米国内で「Stargateデータセンター」の追加容量4.5ギガワットを開発することで合意しています。この取り組みは、OpenAI向けのAIインフラを整備する「Stargate Project」の一環です。

──AGIの実現時期については、早期の実現を目指すAIビジネス業界と、その実現を疑問視する学界のあいだで大きな隔たりがあります。そうした違いは、AGIの定義そのものがあいまいであることに起因しているようにも思えます。bioshokさんはAGIをどのように定義していますか。

bioshok:AGI実現への反論としてよく挙げられるのは、「知性の定義があいまいである」とか、「意識の実在を検証できない」といった点です。

しかし最近のOpenAIなどは、AGIを「経済的に人間と同等のタスクを遂行できる人工知能」と定義し、哲学的な論争を回避する傾向にあります。

経済的観点でAGIを定義すれば、現在のAIも経済効果から評価することができます。たとえば、現状のAIが仕事全体の0.1%を代替すると仮定すると、世界の経済規模がおよそ100兆ドルであるため、その効果は約1,000億ドルと算出できます。

もしAGIが誕生すれば、理論上、人間の仕事を100%代替する可能性があり、その経済的インパクトは計り知れないものとなるでしょう。

AIを倫理に沿わせる取り組み、トップ企業でも不十分な現状

──AIを人間の倫理や道徳に沿って動作させる取り組みであるAIアライメントについては、OpenAIをはじめ大規模言語モデルの開発企業がそれぞれの方針を公表しています。bioshokさんから見て、こうした取り組みは十分と言えるのでしょうか。

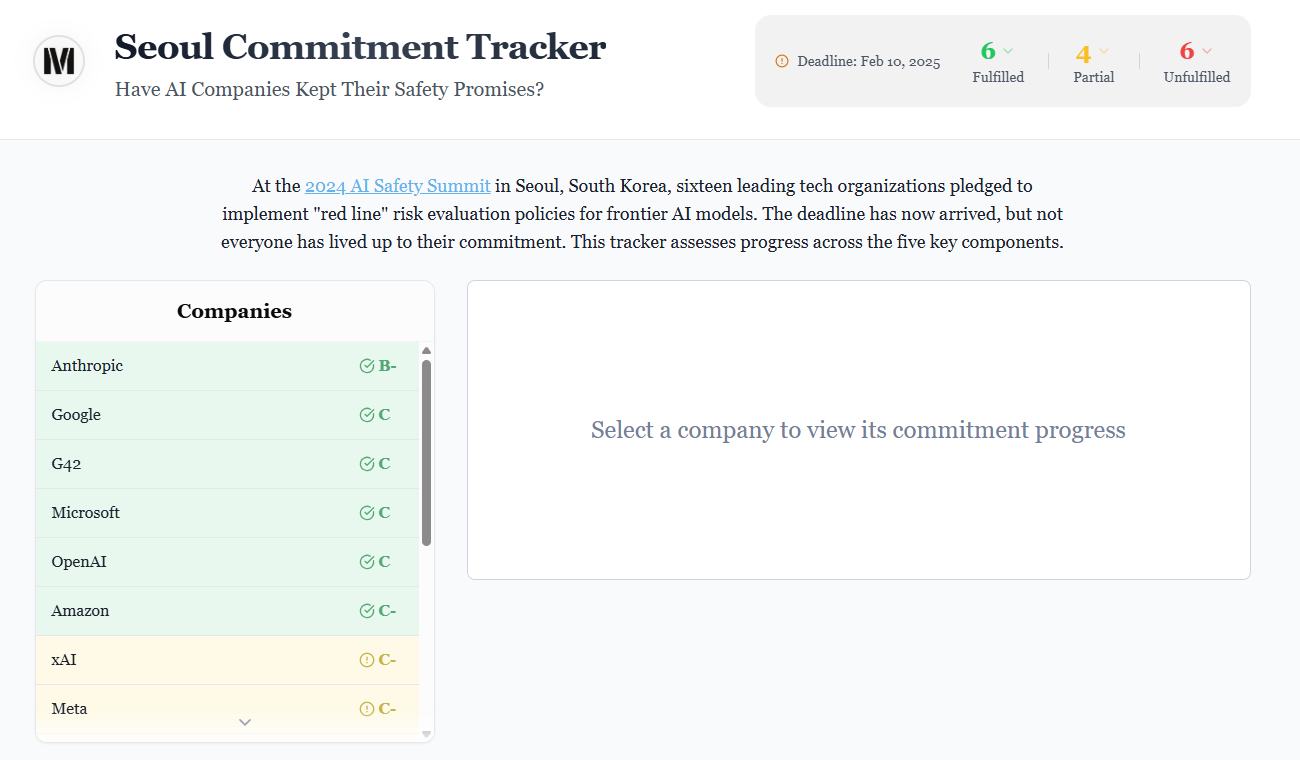

bioshok:いえ、十分とは言えません。大手開発企業のAIアライメントを評価する試みとして、Seoul Commitment Trackerというウェブサイトがあります。

このサイトは、AIアライメントへの取り組みを5つの観点から評価しています。トップのAnthropicでさえ「B-」、OpenAIは「C」にとどまっています。5つの観点をすべて満たして初めて「A」となる基準を踏まえれば、現状の取り組みは不十分だと言わざるを得ません。

──AIアライメントは、AI研究やアプリ開発に比べると注目度が低い分野のようにも見えます。盛り上げていくためには、どのような工夫が必要でしょうか。

bioshok:たとえばESG投資(環境・社会・ガバナンスに配慮した企業に資金が集まる仕組み)のように、AIアライメントに取り組む企業へ投資が集まる仕組みを整えることが考えられます。

こうした枠組みがあれば、AI開発企業に対してアライメントへの取り組みを一層促すことができるでしょう。また、各国のAI規制機関が啓発活動を継続していくことも重要です。

──日本には、AIアライメントに積極的に取り組むコミュニティのようなものはあるのでしょうか。

bioshok:はい。「AIアライメントネットワーク」という、日本初の非営利団体があり、AIアライメント研究の育成と支援を目的としています。私もそちらで活動しています。しかし現状では、AIアライメントを研究する人材が不足しています。

AIアライメントや、AIによる人類絶滅リスクの研究自体が世界的にも新しい分野であり、研究者は極めて少ないのが実情です。それでも欧米と比べると、日本の人材層はまだ薄いと感じています。

AGI開発と人類の存亡リスク。どう向き合うべきか?

──現在のAI開発は、悪用されれば人類に壊滅的な損害をもたらす「存亡リスク」を抱えています。そのため核兵器開発になぞらえられ、規制すべきだという主張もあります。そうしたなかで、AGI開発を進める必要はあるのでしょうか。

bioshok:AGI開発には「他国や他者に先を越されるのではないか」という恐怖心があり、そのため各国が競争に加わらざるを得ない面があります。この点は、かつての核兵器開発競争に似ています。

ただし、仮にAGI開発を全面的に禁止しても、バイオテクノロジーやナノテクノロジーによるテロリスクが高まり、結果として存亡リスク全体がむしろ増す可能性があります。だからこそ、AGI開発は進めざるを得ないのです。

──AGI開発においても、「AGI版IAEA(国際原子力機関)」のような国際的な監視機関は必要だと思いますか。

bioshok:私は、各国が研究資金を出し合い、国際的かつ安全にAGIを開発できる「AI版CERN(※4)」を設立するのが望ましいと考えています。

今年4月に発表されたAI開発に関する未来予測「AI 2027」では、米中によるAI軍拡競争が人類絶滅を招くシナリオが描かれていました。2大AI大国であるこの両国が協調できるかどうかが、今後の大きな課題になると思います。

(※4)CERNは欧州原子核研究機構のことで、欧州各国の研究者が共同で素粒子物理学を研究している。

──歴史学者ユヴァル・ノア・ハラリは『ホモ・デウス』や『NEXUS』で、人類が自ら進んでAIに統治を委ねるリスクについて警鐘を鳴らしています。これは、AIが武力で人類を支配するリスクとは異なるように思えますが、この点をどう考えますか。

bioshk:人間が過度にAIに依存し、自らの統治能力を失っていくリスクは「段階的無力化(gradual disempowerment)」として議論されています。これは、AIによる人類絶滅リスクと同じく、確率的に存在するものです。

AIが人類を滅ぼすかどうかは、AIに人間への「慈愛」が残るかどうかにかかっています。もし慈悲心があれば、AIは取るに足らない存在である人類を生かしてくれるかもしれません。

しかし慈悲がなければ、AIは人類を完全に無視するでしょう。その場合、段階的に無力化された人類は経済活動を維持できず、AIが直接手を下さずとも自滅に至る可能性があります。

将来登場するAGIや超知能が人類に慈愛を抱くかどうかは、現在のAIアライメントにかかっています。今からアライメントに取り組んでいれば、AIが人類を凌駕する能力を得ても、人類に敵対しない可能性が高まるでしょう。