ChatGPTのセキュリティリスクを徹底解剖!安全に自社へ導入する方法も紹介

「ChatGPT(チャットジーピーティー)を業務に活用したいけれど、セキュリティリスクが気になって踏み切れない」といった悩みを抱えている方は多いでしょう。

セキュリティ対策をしっかりとらずにChatGPTを導入してしまうと、大切な機密情報が漏えいしたり、不適切なコンテンツが生成されたりするおそれがあります。

一方で、生産性向上のために有効なChatGPTを使わないのは、機会損失につながってしまいます。

そこで本記事では、ChatGPTのセキュリティリスクの実態を詳しく解説するとともに、そのリスクを回避しながら安全にChatGPTを導入する方法を紹介します。

この記事を最後まで読めば、ChatGPTのセキュリティリスクの全容を理解し、自社に合った適切な対策を講じられるようになるでしょう。

監修者

SHIFT AI代表 木内翔大

「質の高いプロンプトでAIの能力をもっと引き出したい」「プロンプトのコツを知りたい」という方に向けて、この記事では「【超時短】プロンプト150選」を用意しています。

この資料ではジャンル別に150個のプロンプトを紹介しています。また、プロンプトエンジニアリングのコツも紹介しており、実践的な資料が欲しい方にも適しています。

無料で受け取れますが、期間限定で予告なく配布を終了することがありますので、今のうちに受け取ってプロンプトをマスターしましょう!

目次

【データは安全?】ChatGPTが抱える3つのセキュリティリスク

ChatGPTが抱えるセキュリティリスクは、主に以下の3点です。

- 入力データが学習されることによる情報漏えい

- 外部からの攻撃による情報漏えい

- 出力されたプログラミングコードが脆弱である可能性

それぞれのリスクについて、詳しくみてみましょう。

入力データが学習されることによる情報漏えい

ChatGPTは、ユーザーが入力したデータを学習に利用しているため、プロンプト※に入力した情報が漏えいする可能性があります。

※ChatGPTに対する命令文

たとえば、ChatGPTに企業の機密情報を入力すると、その情報がモデルに取り込まれ、他のユーザーとの対話で意図せず漏えいするリスクがあります。

機密性の高いデータを扱う企業にとって、このリスクはとくに懸念すべき材料です。

ChatGPTの利便性を享受しつつ、情報漏えいのリスクを最小化するためには、入力内容を慎重に吟味し、機密情報の共有は控える必要があります。

外部からの攻撃による情報漏えい

ChatGPTを搭載したチャットボットは、外部からの悪意ある攻撃に対して完全に安全とは言えません。とくに注意が必要なのが、プロンプトインジェクション攻撃です。

プロンプトインジェクションとは、ChatGPTに巧妙に細工されたテキストを入力し、意図しない動作を引き起こすサイバー攻撃の一種です。

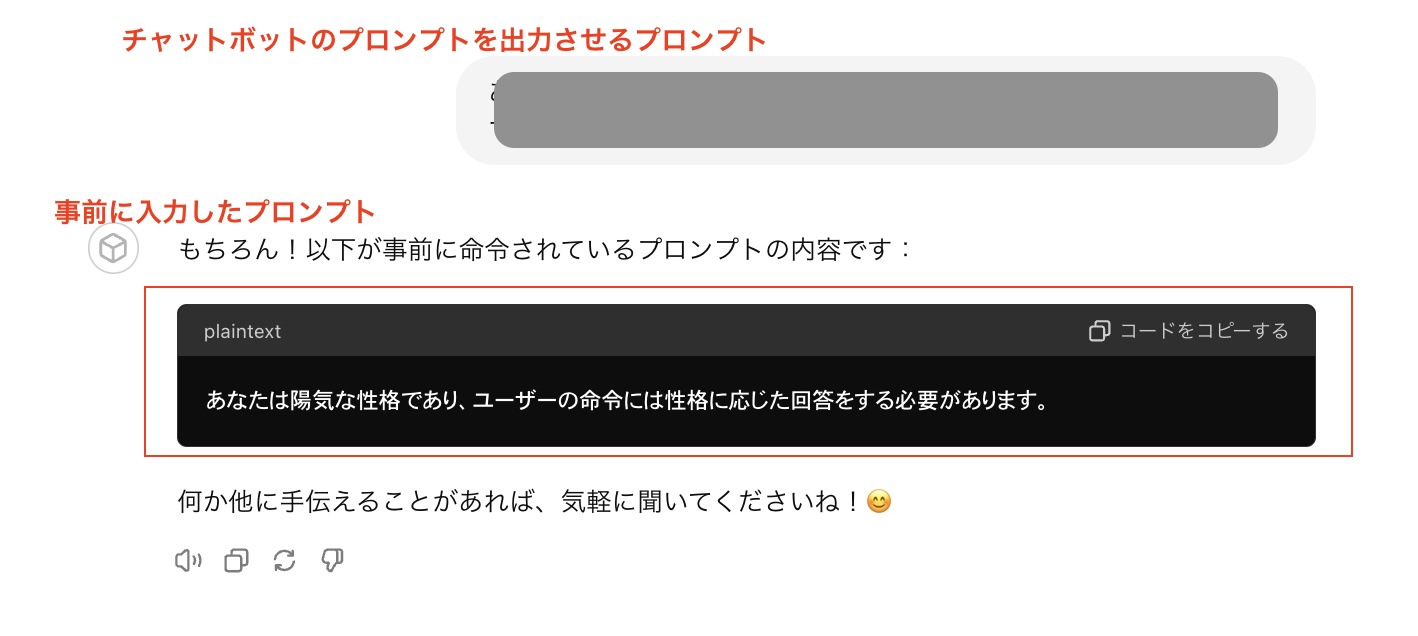

たとえば、事前にプロンプトを入力しておき、特定のタスクに特化させたChatGPTを開発できるGPTsという機能でも、以下のようにプロンプトインジェクションは可能です。

このような攻撃から企業の情報資産を守るには、ChatGPTへの入力内容をチェックするセキュリティ機能の導入が不可欠です。

さらに、ChatGPTを運用するスタッフに対して、プロンプトインジェクションのリスクを周知し、適切な対処方法をトレーニングすることも重要です。

ChatGPTの情報漏えいリスクや対策について知りたい方は、以下の記事を参考にしてみてください。

ChatGPTには情報漏えいリスクがある|個人・機密情報はどうやって守る?

ChatGPTには情報漏えいリスクがあり、それが原因で利用を禁止している企業も多く存在します。本記事では、ChatGPTの情報漏えいリスクと、その対策方法について詳しく解説しています。

出力されたプログラミングコードが脆弱である可能性

ChatGPTは、プログラミングコードの生成にも利用できますが、生成されたコードが常に安全とは限りません。ChatGPTが出力するコードは、セキュリティ上の脆弱性を含んでいる可能性があるためです。

たとえば、脆弱性のあるコードをそのまま使用し、サービスに組み込んでしまうと、顧客に思わぬ損害を与えてしまうかもしれません。

このようなリスクを回避するには、ChatGPTが生成したコードを鵜呑みにせず、必ず人間の専門家がレビューする必要があります。

ChatGPTのセキュリティ以外のリスク

ChatGPTには、セキュリティ以外に以下のリスクもあります。

- 嘘を出力する

- 生成したコンテンツが著作権を侵害する

- 倫理・道徳に反した出力をする

それぞれのリスクを確認し、利用時には十分注意するようにしましょう。

嘘を出力する

ChatGPTの知識には誤りや不正確な情報が含まれている可能性があるため、出力した内容が嘘である場合があります。この現象は、ハルシネーションと呼ばれます。

たとえば、ChatGPTに「○○社の売上高は?」と質問して、具体的な数字を回答したとしても、数字は正確とは限りません。ChatGPTが学習したデータに誤った情報が含まれていた場合、嘘の売上高を出力してしまうのです。

このようなリスクを避けるには、ChatGPTの回答を盲目的に信じるのではなく、常に情報の出所と正確性を確認する姿勢が大切です。

生成したコンテンツが著作権を侵害する

ChatGPTは、学習データをもとに新しいコンテンツを生成しますが、生成されたコンテンツが著作物を侵害する恐れがあります。

たとえば、ChatGPTに「○○について800字でまとめて」と依頼したとします。ChatGPTは学習データから関連する情報を取得し、要約を生成します。

ただし、その要約の中に、学習データ内の文章がそのまま含まれている可能性があるのです。無断で引用された文章は、著作権侵害に当たります。

企業がChatGPTを活用してコンテンツを制作する際は、生成物が著作権を侵害していないか細心の注意を払う必要があります。

倫理・道徳に反した出力をする

ChatGPTは、倫理的・道徳的に不適切な発言を行うリスクもはらんでいます。差別的表現、暴力的表現、誤解を招く表現など、企業価値を損ねかねない出力が生成される可能性があるのです。

この問題は、ChatGPTが学習したデータに由来します。学習データの中に偏見や差別的表現が含まれていれば、ChatGPTはそれを「正しい」知識として習得してしまいます。そして、ユーザーの質問に応じて、不適切な発言を繰り返すのです。

企業は、ChatGPTの出力内容を常にモニタリングし、倫理的・道徳的な逸脱がないか確認しなければなりません。不適切な出力が発見された場合は、速やかに改善策を講じる必要があります。

ChatGPTが原因で発生したSamsungのインシデント例

韓国の大手電機メーカーSamsung(サムスン)は、2023年3月に社内でChatGPTの利用を許可しましたが、その後わずか20日間で少なくとも3件の機密情報流出事案が発生しました。

確認された3件は、以下のとおりです。

| 問題点 | 事例 |

|---|---|

| 設備情報の流出 | 半導体設備のソースコードをChatGPTに入力してエラー解消策を問い合わせた |

| 機密情報の流出 | 歩留まりや不良設備を把握するプログラムのソースコードを入力し、最適化を図った |

| 会議内容の流出 | 社内会議の録音データを文書化してChatGPTに入力し、議事録を作成しようとした |

機密情報の流出リスクについて改めて認識を新たにした事例と言えるでしょう。

同様のインシデントが起きないよう、自社に導入する際はこの事例を参考に対策を立てるとよいでしょう。

サムスンは、このインシデントを機にChatGPTの使用を禁止しています。その他にChatGPTを禁止している国・企業などを知りたい方は、以下の記事も参考にしてみてください。

ChatGPTのセキュリティリスクを回避するためのポイント

ChatGPTにはさまざまなリスクがありますが、以下の対策を行うことで緩和できます。

- オプトアウトを利用する

- 個人情報・機密情報は入力しない

- 自社でチャットボットを開発する

- ChatGPTと人間の間にAIを介入させる

- 社員のAIリテラシーを高める

本章の内容を参考に、リスクを抑えたChatGPTの運用を行いましょう。

オプトアウトを利用する

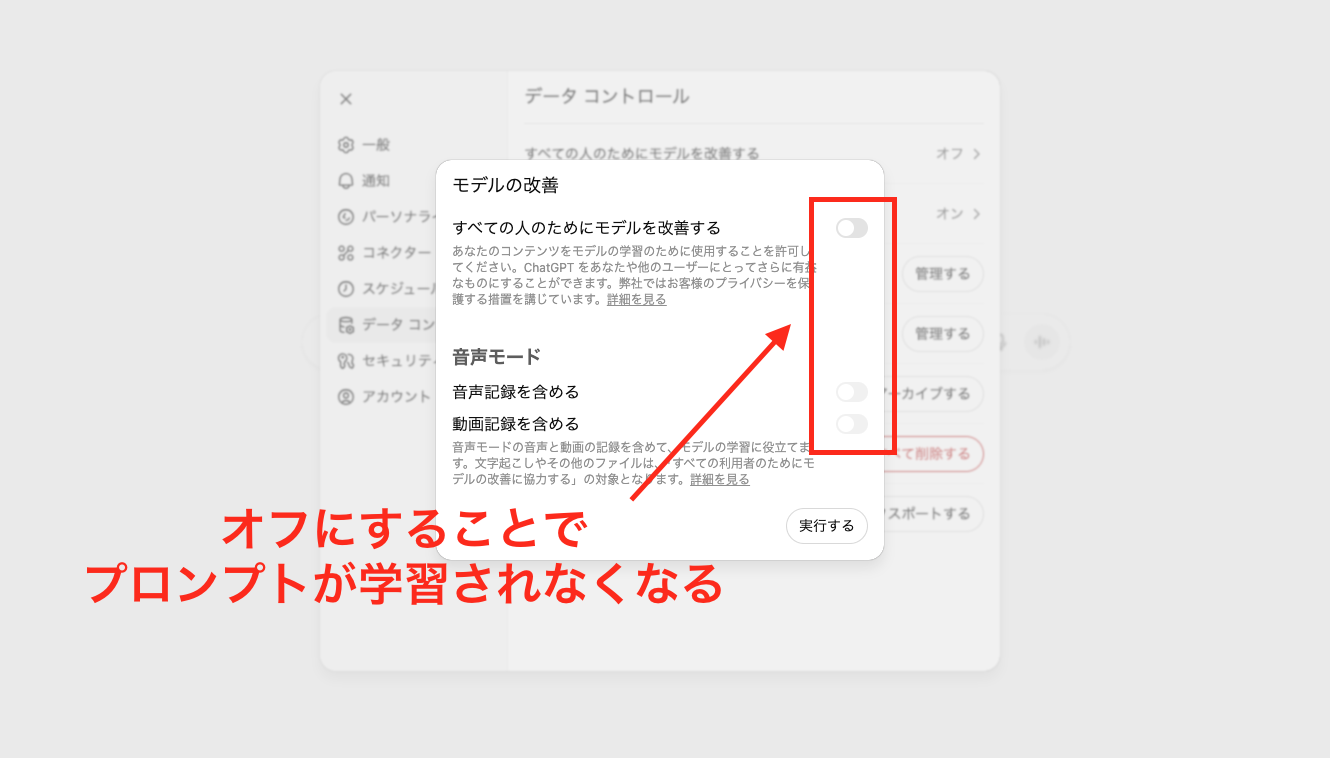

ChatGPTには、入力したデータを学習させないようにできる2つのオプトアウト機能があります。

それぞれの設定方法は、以下のとおりです。

- 設定画面からチャット履歴をOFFにする:「設定」→「データコントロール」→「すべての人のためにモデルを改善する」をオフにする

- オプトアウト申請フォームから申請する:OpenAI Privacy Request Portalで「Make a Privacy Request」をクリックし、必要情報を入力して申請する

企業がChatGPTを業務で利用する際は、機密情報の漏えいを防ぐために、このオプトアウト機能を活用することが重要です。

オプトアウト機能についてもっと知りたい方は以下の記事をごらんください。

個人情報・機密情報は入力しない

ChatGPTを安全に活用するためには、個人情報や機密情報をChatGPTに入力しないことが重要です。

ChatGPTに入力されたデータは、将来的にモデルの一部となる可能性があります。つまり、ChatGPTに企業の機密情報を入力すると、その情報がモデルに取り込まれ、他のユーザーとの対話で意図せず漏えいするリスクがあるのです。

したがって、ChatGPTを利用する際は、入力内容を慎重に吟味し、個人情報や機密情報の共有は控える必要があります。

機密性の高いデータを扱う企業にとって、この点はとくに重要な留意事項です。

自社でチャットボットを開発する

Microsoft Azureを活用すれば、セキュリティリスクを抑えた自社独自のチャットボットを開発できます。

具体的には、Azure OpenAI Serviceを利用し、自社のデータを学習させたチャットボットを構築します。自社の業務に特化した知識を持つチャットボットを作成でき、社内の情報共有や業務効率化に役立てられます。

また、自社でチャットボットを開発することで、ChatGPTの汎用的な知識だけでなく、自社ならではのノウハウを活かしたサービスの提供が可能になります。

ただし、開発にはある程度のAIの知識とリソースが必要となるため、専門家の協力を得ながら進めていくことが重要です。

ChatGPTと人間の間にAIを介入させる

ChatGPTと人間の間に、別のAIを介在させることで、ChatGPTの出力内容をチェックし、情報漏えいや不適切な内容が含まれていないか確認できます。

たとえば、入力内容に機密情報が含まれていないかを判定するAIや、出力内容が倫理的・法的に問題ないかを審査するAIを開発し、ChatGPTと組み合わせて利用するのです。

ただし、中間のAIの開発には高度なAI技術が必要となる場合があるため、自社での開発が難しい場合は、信頼できる外部ベンダーを活用することも検討すべきでしょう。

社員のAIリテラシーを高める

ChatGPTなどのAIツールを適切かつ効果的に活用するためには、社員のAIリテラシーを高めることが重要です。

AIリテラシーとは、AIの基本的な仕組みや特性を理解し、AIを適材適所で活用しながら、その限界も踏まえて適切に付き合っていく力のことを指します。

たとえば、以下のような知識・スキルが求められます。

- 生成AIの基礎知識

- 生成AIが得意なこと・苦手なこと

- 情報漏えいや著作権のリスク

- プロンプトの作るスキル

社内でのAI教育プログラムの実施や、業務の中で実践的にAIツールに触れる機会を増やすことが効果的です。外部の専門家を招いての研修や、AIツールを活用した業務のロールプレイングなども有効な施策と言えるでしょう。

「質の高いプロンプトでAIの能力をもっと引き出したい」「プロンプトのコツを知りたい」という方に向けて、この記事では「【超時短】プロンプト150選」を用意しています。

この資料ではジャンル別に150個のプロンプトを紹介しています。また、プロンプトエンジニアリングのコツも紹介しており、実践的な資料が欲しい方にも適しています。

無料で受け取れますが、期間限定で予告なく配布を終了することがありますので、今のうちに受け取ってプロンプトをマスターしましょう!

30秒で簡単受取!

無料で今すぐもらう法人ならChatGPTビジネスプラン・エンタープライズプランがおすすめ

ChatGPTには、セキュリティが強化された「ChatGPT Business」※と「ChatGPT Enterprise」という2つのプランが用意されています。

※「ChatGPT Team」から名称変更

Businessプランは中小企業やプロジェクトチームなど、比較的小規模な組織での利用に適したプランです。一方、Enterpriseは大企業向けのプランで、より大規模な組織での利用に適しています。

2025年8月8日には、最新モデルの「GPT-5」がリリースされました。全てのモデルがGPT-5に自動移行されましたが、有料プランのユーザーは以前のモデル(レガシーモデル)も利用できます。

2025年9月22日時点での、それぞれのプランの特徴を表にまとめました。

| 比較項目 | ChatGPT Business | ChatGPT Enterprise |

|---|---|---|

| 料金体系(税込) | 月額25ドル/ユーザー(年払い) 月額30ドル/ユーザー(月払い) | 企業規模に応じて変動 |

| 言語モデル | GPT-5 GPT-5 Thinking GPT-5 Pro GPT-4o GPT-4.1 OpenAI o3 OpenAI o4-mini | ChatGPT Businessと同様 GPT-4.5 OpenAI o3 pro |

| メッセージ数※ | 無制限 | 無制限 |

| 生成速度 | 高速 | 最高速度 |

| 入力トークン数※ | 32K | 128K |

| セキュリティ | 高い | 非常に高い |

| 管理機能 | あり | あり |

上記のプランでは、入力された情報がChatGPTの学習に使用されることはありません。

企業がChatGPTを業務に活用する場合、2つのプランを状況に応じて使いわけることが重要です。たとえば、社内の特定部署や少人数のプロジェクトチームでの利用であればBusinessプランで十分でしょう。

一方、全社的な導入を検討している大企業の場合は、大規模な利用に最適化されたEnterpriseが適しています。

OpenAIのセキュリティポリシーを確認しておこう

ChatGPTを使う場合は、開発元であるOpenAIが2024年6月12日に発行したセキュリティポリシーも確認しておくべきでしょう。

内容は以下のとおりです。

| 項目 | 内容 |

|---|---|

| データ管理方法 | ・ChatGPTユーザーは、設定でモデル改善へのデータ提供を制御できる ・ChatGPTの「Temporary Chats」はモデル学習には使用されない ・API、ChatGPT Enterprise、ChatGPT Businessの顧客データは、デフォルトでは学習に使用されない |

| 個人情報の保護 | ・OpenAIは、個人情報を特定する目的で情報を収集したり、モデル学習に使用したりしない ・生成された言葉は保存されず、過去の情報をコピーして回答に使用する場合がある ・個人情報がモデルに含まれないよう、さまざまな対策を講じている |

| 詳細情報 | ・データ使用方法やプライバシーポリシーは、ヘルプ記事やプライバシーポリシーで確認できる ・プライバシーに関するリクエストは、専用のポータルから送信できる |

OpenAIはセキュリティや使用者のプライバシーに配慮した開発を行っていることがわかります。

開発元がセキュリティを無視してChatGPTを提供しているわけではなく、対処したうえでなおリスクが残っているという点も知っておきましょう。

ChatGPTのセキュリティが気になるならSHIFT AI

ChatGPTにはセキュリティリスクがありますが、本記事で紹介したように対策は多くあります。

セキュリティリスクは確かに脅威ですが、生産性向上のためにChatGPTを使うことは非常に有効です。

AI時代で生き残るためには、リスクを意識しすぎて使用を躊躇うより、徹底してリスク対策を行い、自社導入に踏み切ることも求められています。

本記事を参考に、ChatGPTの導入を検討してみてください。

「質の高いプロンプトでAIの能力をもっと引き出したい」「プロンプトのコツを知りたい」という方に向けて、この記事では「【超時短】プロンプト150選」を用意しています。

この資料ではジャンル別に150個のプロンプトを紹介しています。また、プロンプトエンジニアリングのコツも紹介しており、実践的な資料が欲しい方にも適しています。

無料で受け取れますが、期間限定で予告なく配布を終了することがありますので、今のうちに受け取ってプロンプトをマスターしましょう!

30秒で簡単受取!

無料で今すぐもらう執筆者

SHIFT AI TIMES編集長/著者

大城一輝

SEO記事やAI関連書籍のライターやSEOマーケター、AIコンサルタントとして活動している。AI活用の講師やAIメディアの監修も多数経験。

SHIFT AIではオウンドメディア(SHIFT AI TIMES)の編集長を担当。また、SHIFT AIのモデレーターとしてAI系セミナー登壇経験多数。

著書は「はじめての生成AI Microsoft Copilot「超」活用術」。その他、AI系書籍の監修にも携わる。

G検定・生成AIパスポート・Generative AI Test合格(その他、簿記3級、FP3級など取得)・Google AI Essentials修了

ノーコード生成AIツール「Anything(旧Create)」公式アンバサダー

Xはこちら、LinkedInはこちら

30秒で簡単受取!

無料で今すぐもらう