動画生成AI「FramePack」をローカル構築して動画を作る方法を解説!

FramePack(フレームパック)は、1枚の画像から最大120秒の動画を生成できるAIツールです。

わずか6GBのGPUメモリで動作し、長尺でも滑らかで一貫性のある映像を生成できることから、動画生成AIの新たな可能性を切り開いています。

wanを使用してきた方は「数秒で終わってしまう」「長くすると破綻する」といった悩みがあるかもしれません。

FramePackでは最大120秒の長尺でも自然なアニメーションを実現できる点が大きな特徴です。

本記事では、FramePackの特徴や料金、始め方、使い方、実際に生成した動画の事例など詳しく解説します。

本記事を参考にFramePackの概要を理解し、画像から最大120秒の動画を生成してみましょう。

監修者

SHIFT AI代表 木内翔大

「質の高いプロンプトでAIの能力をもっと引き出したい」「プロンプトのコツを知りたい」という方に向けて、この記事では「【超時短】プロンプト150選」を用意しています。

この資料ではジャンル別に150個のプロンプトを紹介しています。また、プロンプトエンジニアリングのコツも紹介しており、実践的な資料が欲しい方にも適しています。

無料で受け取れますが、期間限定で予告なく配布を終了することがありますので、今のうちに受け取ってプロンプトをマスターしましょう!

目次

FramePackとは?

FramePack(フレームパック)は、1枚の画像から最大120秒の動画を生成できるAIツールです。

従来の動画生成AIでは、数秒の短い動画しか作れず、とくに長尺になると「メモリの消費増大」や「画質の劣化」といった問題が発生し、実用化が困難でした。

FramePackは、次フレーム予測と独自の圧縮アルゴリズムを組み合わせて、処理コストを一定に保ちながら、滑らかで高品質な長尺動画を生成できます。

実際に、短尺でも画質の違いが明確に現れるのかを検証するため、以下のプロンプトでwanとFramePackの両方を使って、約10秒間の動画を生成しました。

The character stands still while the wind gently moves their hair and clothes.【和訳】キャラクターはじっと立っていて、風がやさしく髪や服を揺らしている

実際に同じプロンプトと画像から生成した約10秒の動画を比較してみても、画質の違いは明らかです。

FramePackは、髪の揺れや輪郭の安定性が高く、フレームごとの破綻が少ない出力を実現できます。

FramePackを使えば、画質の高い動画を安定して生成できるため、生成精度や継続性を検証しやすくなり、チーム内での共有や技術提案にも役立ちます。

FramePackの特徴

FramePackの特徴は以下の3つです。

- 画像1枚から最大120秒の動画生成可能

- 最低6GBのGPUメモリで動作可能

- TeaCacheを使用すれば1フレーム約1.5秒で生成可能

それぞれの特徴について詳しく解説していきます。

画像1枚から最大120秒の動画生成可能

FramePackの最大の特徴は、たった1枚の静止画から最大約120秒の長尺動画を生成できる点です。

FramePackは、直前のフレームを圧縮して文脈として利用し次のフレームを滑らかに生成する構造を採用しています。

たとえば以下は、FramePackを使って1枚の静止画像から生成された動画の一例です。

DJの静止画から手や表情が動き出す動画へと変化しています。長尺の動画でも破綻なく生成できるため、他のツールでは難しかった2分規模の映像検証や表現試作も行えます。

最低6GBのGPUメモリで動作可能

高性能GPUが必須な長尺の動画生成も、FramePackなら最低6GBのGPUでも動作できます。

従来の動画生成AIは、最低でも10GB以上のVRAMを必要とする場合が多く、環境構築のハードルも高くなりがちでした。

FramePackはフレーム圧縮やメモリ効率の最適化により、処理コストを抑えています。

実際に、NVIDIA RTX 3060(6GB VRAM)を搭載したノートパソコンで、60秒で30fpsの動画生成が安定して行えたと公式でも報告されています。

高性能GPUがなくても、長尺動画の生成や検証を始められます。

「TeaCache」機能を使用すれば1フレーム約1.5秒で生成可能

FramePackでは、「TeaCache」機能を使うことで、フレーム生成速度を大幅に短縮できます。

「TeaCache」機能は、生成過程の一部計算をキャッシュとして再利用する仕組みで、拡散処理を簡略化し、1フレームあたりの処理時間を高速化します。

実際に、RTX 4090を使用した環境では、通常約2.5秒かかる1フレームの生成処理が「TeaCache」機能を有効にすると約1.5秒まで短縮された事例が公式で報告されています。

フレーム数の多い長尺動画を生成する際でも、「TeaCache」機能を使えば検証スピードを大幅に上げられるため、試行回数やプロンプトを効率化できます。

FramePackの料金プラン

FramePackは、高精度な動画生成を完全無料で利用できます。

FramePackはGitHubで無償公開されており、ダウンロードや利用にライセンス料、サブスクリプション契約は一切必要ありません。

さらに、Apache 2.0ライセンスのもとで提供されているため、改変や再配布も自由に行えます。

初期コストをかけずに長尺の動画生成を試せるため、学習用や検証用としても導入しやすいのが魅力です。

「質の高いプロンプトでAIの能力をもっと引き出したい」「プロンプトのコツを知りたい」という方に向けて、この記事では「【超時短】プロンプト150選」を用意しています。

この資料ではジャンル別に150個のプロンプトを紹介しています。また、プロンプトエンジニアリングのコツも紹介しており、実践的な資料が欲しい方にも適しています。

無料で受け取れますが、期間限定で予告なく配布を終了することがありますので、今のうちに受け取ってプロンプトをマスターしましょう!

30秒で簡単受取!

無料で今すぐもらうFramePackは商用利用可能?

FramePackは、基本的に商用利用が可能です。

Apache 2.0ライセンスは、「改変や再配布が自由なだけでなく、商用利用も許可されている」ライセンスとして広く使われています。

実際、Apache 2.0ライセンスでは以下のように明記されています。

「Subject to the terms and conditions of this License, each Contributor hereby grants to You a perpetual, worldwide, non-exclusive, no-charge, royalty-free, irrevocable copyright license to reproduce, prepare Derivative Works of, publicly display, publicly perform, sublicense, and distribute the Work and such Derivative Works in Source or Object form.」

【和訳】本ライセンスの条項と条件に従う限り、各貢献者は、あなた(使用者)に対して、当該作品およびその派生作品を「複製」「改変」「公に表示・上演」「サブライセンス付与」「配布」することができる、永続的で、全世界的、非独占的、無償、ロイヤリティフリー、かつ取消不能な著作権ライセンスを付与します(ソース形式またはオブジェクト形式のいずれでも可)。

Apache 2.0ライセンス

商用利用が認められているため、追加費用やライセンス交渉なしで、企業やクライアント向けのプロジェクトにもそのまま活用できます。

FramePackを利用するために必要なスペックと推奨環境

FramePackを利用するには、NVIDIA製GPU(VRAM 6GB以上)と50GB以上の空きストレージを備えたパソコンが必要です。

公式が公開している推奨環境は以下のとおりです。

| 項目 | 推薦スペック | 補足 |

|---|---|---|

| GPU | NVIDIA RTX 30シリーズ以上(6GB以上) | 8GB以上推奨、FP16/BF16対応必須 |

| CPU | Core i7 第10世代以上または同等Ryzen | 処理の大半はGPU側で実行 |

| メモリ | 16GB以上(32GB推奨) | GUI操作や長尺動画に安定性 |

| OS | Windows 10/11(64bit)またはLinux | macOSは非対応 |

| Python | 3.10.x(Windows版は同梱) | Linuxは自前セットアップ必要 |

| PyTorch | 2.6以降(CUDA12.6対応ビルド) | CUDA対応GPUが必須 |

| ストレージ | 空き容量50GB以上 | モデルDL(30GB)+一時ファイル含む |

このスペックさえ満たせば、FramePackはローカルでもクラウドでも問題なく動作し、長尺の滑らかな動画生成をすぐに始められます。

Colabのようなクラウド環境でも必要なスペックを満たせば動作するため、自身のパソコンに高性能なGPUがなくても導入できます。

FramePackの始め方

FramePackを始める方法は複数ありますが、ここでは代表的な3つを紹介します。

- 「ワンクリックパッケージ」で始める方法

- Linuxで始める方法

- Google Colabで始める方法

ご自身の環境に合わせて、FramePackを始めてみましょう。

「ワンクリックパッケージ」で始める方法

Windowsユーザーであれば、PythonやPyTorchのセットアップ経験がなくても、公式の「ワンクリックパッケージ」を使うだけでFramePackを導入できます。

ワンクリックパッケージには、必要なPython環境やPyTorch、CUDAなどのライブラリがすべて同梱されています。

以下に、公式が推奨するWindows環境でのインストール手順を示します。

①パッケージをダウンロードする

公式GitHubのREADMEにある「Click Here to Download One-Click Package」から、ZIPファイルをダウンロードします。

②ZIPファイルを解凍する

ダウンロードしたZIPを解凍し「update.bat」「run.bat」が含まれているかを確認します。

③アップデートを実行する

最初に「update.bat」をクリックして実行します。これにより、パッケージの内容が最新の状態に更新されます。

④起動とモデルのダウンロードする

次に「run.bat」を実行すると、初回起動時に30GB以上のモデルファイルが自動でダウンロードされます。インターネット回線の状況により、完了まで数分~十数分かかる場合があります。

⑤GUIの表示する

ダウンロード完了後、Webブラウザが自動で起動し、Gradioベースの生成UIが表示されます。

表示されない場合は、コマンドプロンプトに出力されたURL(例:http://127.0.0.1:7860)を手動で開いてください。

PythonやPyTorchのバージョン管理、CUDAのビルド設定などを手動で行う必要がないため、初めて動画生成AIを試す方でもすぐに利用を開始できます。

Linuxで始める方法

Linux環境でも、仮想環境を使って依存ライブラリを整えれば、FramePackを安定して動かせます。

Python 3.10がインストールされていれば、複雑なビルドや特殊な設定は不要です。

以下は、Linux上でFramePackをセットアップする手順です。

①コードを取得する

ターミナルで以下を実行してコードを取得します。

git clone https://github.com/lllyasviel/FramePack.git

cd FramePack②仮想環境を作成し有効化する(任意)

既存の環境に影響を与えたくない場合は、以下で仮想環境を構築しましょう。

python3.10 -m venv .venv

source .venv/bin/activate③PyTorch(CUDA対応)をインストールする

以下のコマンドで、CUDA 12.6対応のPyTorchをインストールします。

pip install torch torchvision torchaudio --index-url https://download.pytorch.org/whl/cu126④依存ライブラリをインストールする

コード内のrequirements.txtを使って必要なライブラリをインストールします。

pip install -r requirements.txt⑤GUIを起動する

以下のコマンドでGradioベースのGUIを起動します。

python demo_gradio.py初回起動時には30GB以上のモデルが自動でダウンロードされ、完了後にローカルURL(例:http://127.0.0.1:7860)が表示されます。

Linuxユーザーでも、仮想環境と基本的なコマンド操作ができれば、FramePackで動画を生成できます。まずはコードを取得して、仮想環境を立ち上げてみましょう。

Google Colabで使う方法

高性能なGPUが手元になくても、FramePackはGoogle Colabを使えば60秒の長尺動画も問題なく生成できます。

筆者のローカル環境ではスペックが不足していたため、Colab Pro+を活用して動画を生成しました。

Colabの無料プランは、メモリやセッション時間に制限があります。モデルの読み込みや動画生成が途中で止まる場合があるので注意しましょう。

安定した動作を求める場合は、Colab ProまたはPro+の利用がおすすめです。料金についてはGoogle Colab公式サイトをご確認ください。

以下は、Colab上でFramePackを使うための準備手順です。

①Colabノートブックを開く

Google Colabにアクセスし「新しいノートブック」を作成します。

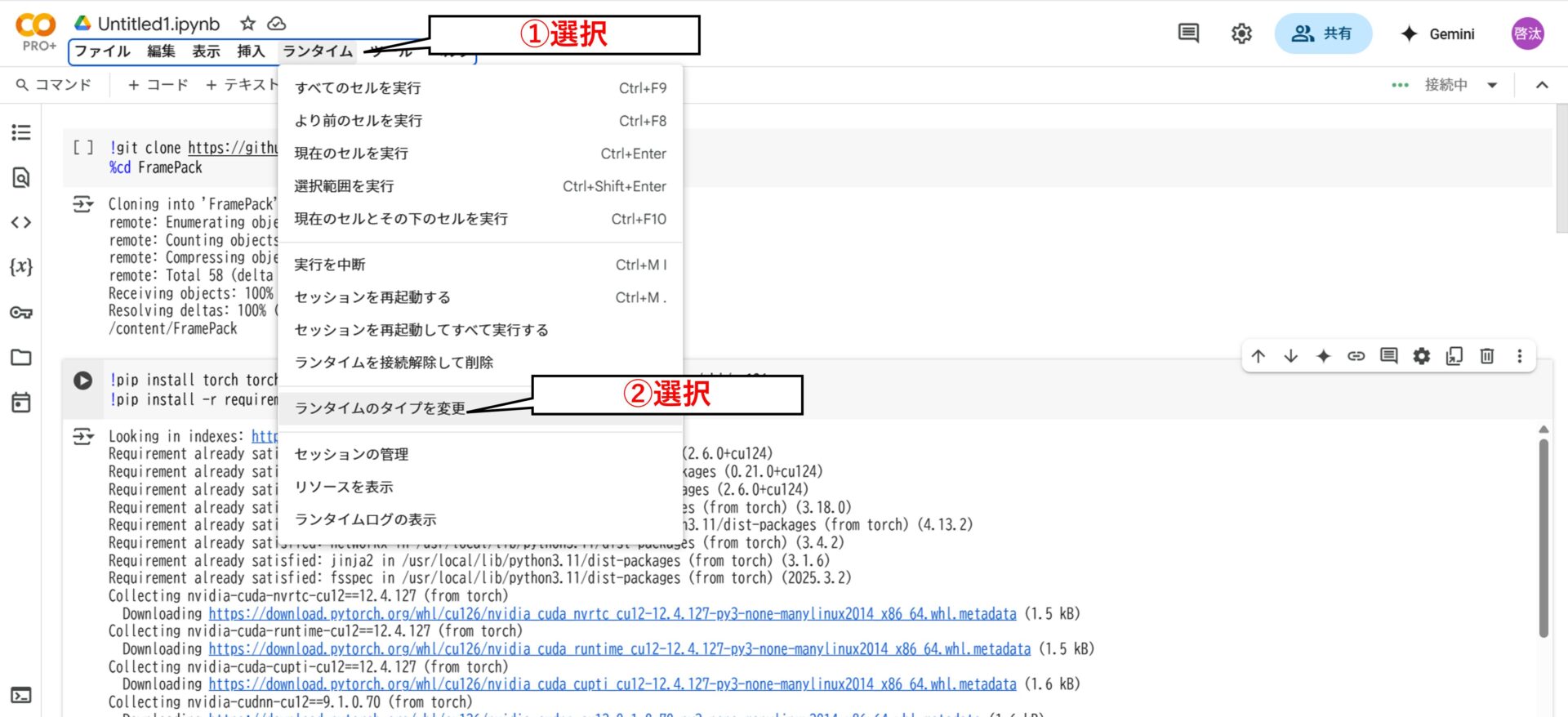

②GPUを有効化する

画面上部メニューから「ランタイム」、「ランタイムのタイプを変更」を選択し「L4 GPU」または「A100 GPU」選択します。

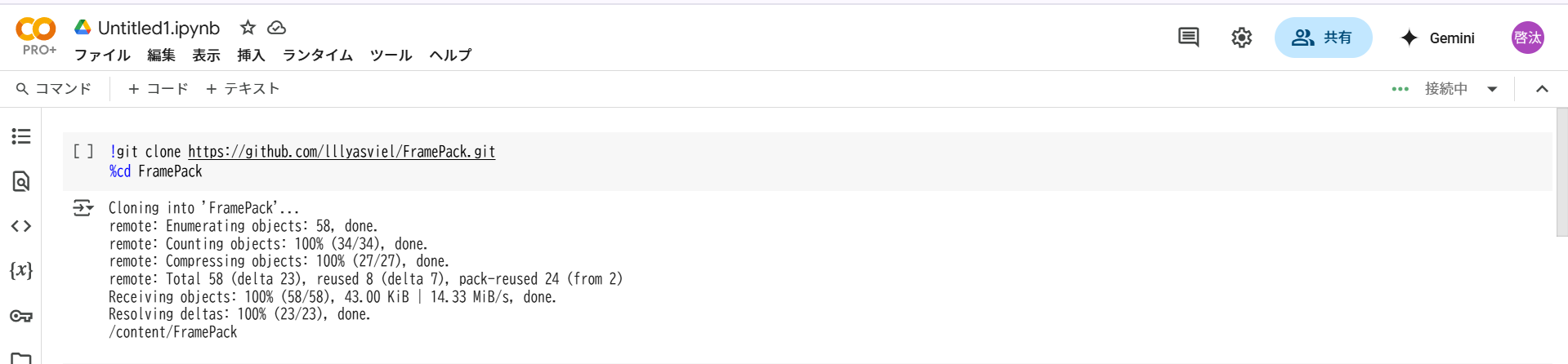

③FramePackをコピーする

以下のコマンドで、GitHubからFramePackを取得し、作業ディレクトリに移動します。

!git clone https://github.com/lllyasviel/FramePack.git

%cd FramePack

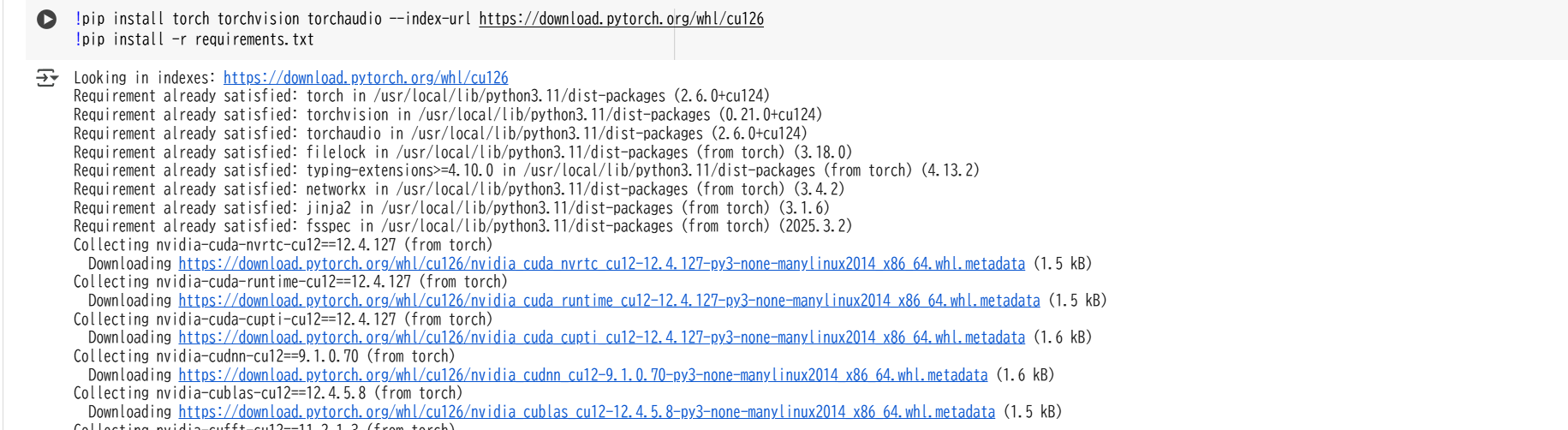

④PyTorchと依存ライブラリをインストール(約2~3分)

Colabの環境に合わせて、PyTorch(CUDA 12.6対応)とFramePackの依存パッケージをインストールします。

!pip install torch torchvision torchaudio --index-url https://download.pytorch.org/whl/cu126

!pip install -r requirements.txt

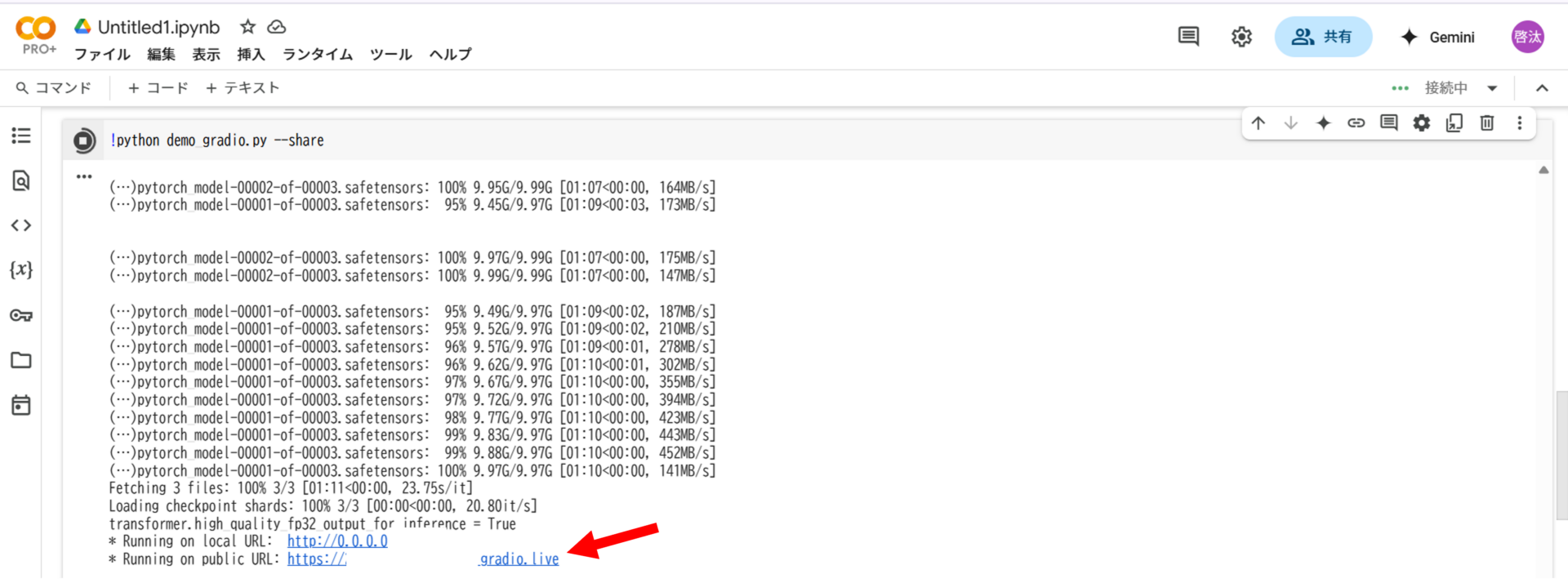

⑤GUIを起動(約5~6分)

ダウンロード完了後、Webブラウザが自動で起動し、Gradioベースの生成UIが表示されます。

!python demo_gradio.py --share

実行が完了すると「Running on public URL: https://xxxx.gradio.live」のようなリンクが表示されます。リンクを選択するとFramePackの画面(GUI)が立ち上がります。

「質の高いプロンプトでAIの能力をもっと引き出したい」「プロンプトのコツを知りたい」という方に向けて、この記事では「【超時短】プロンプト150選」を用意しています。

この資料ではジャンル別に150個のプロンプトを紹介しています。また、プロンプトエンジニアリングのコツも紹介しており、実践的な資料が欲しい方にも適しています。

無料で受け取れますが、期間限定で予告なく配布を終了することがありますので、今のうちに受け取ってプロンプトをマスターしましょう!

30秒で簡単受取!

無料で今すぐもらうFramePackの使い方

FramePackの使い方を以下の3つに分けて解説します。

- 画像の選択とプロンプトの設定方法

- 出力設定の調整方法

- 動画の生成と保存

実際の操作画面も載せているので、一緒に手を動かしながら進めてみましょう。

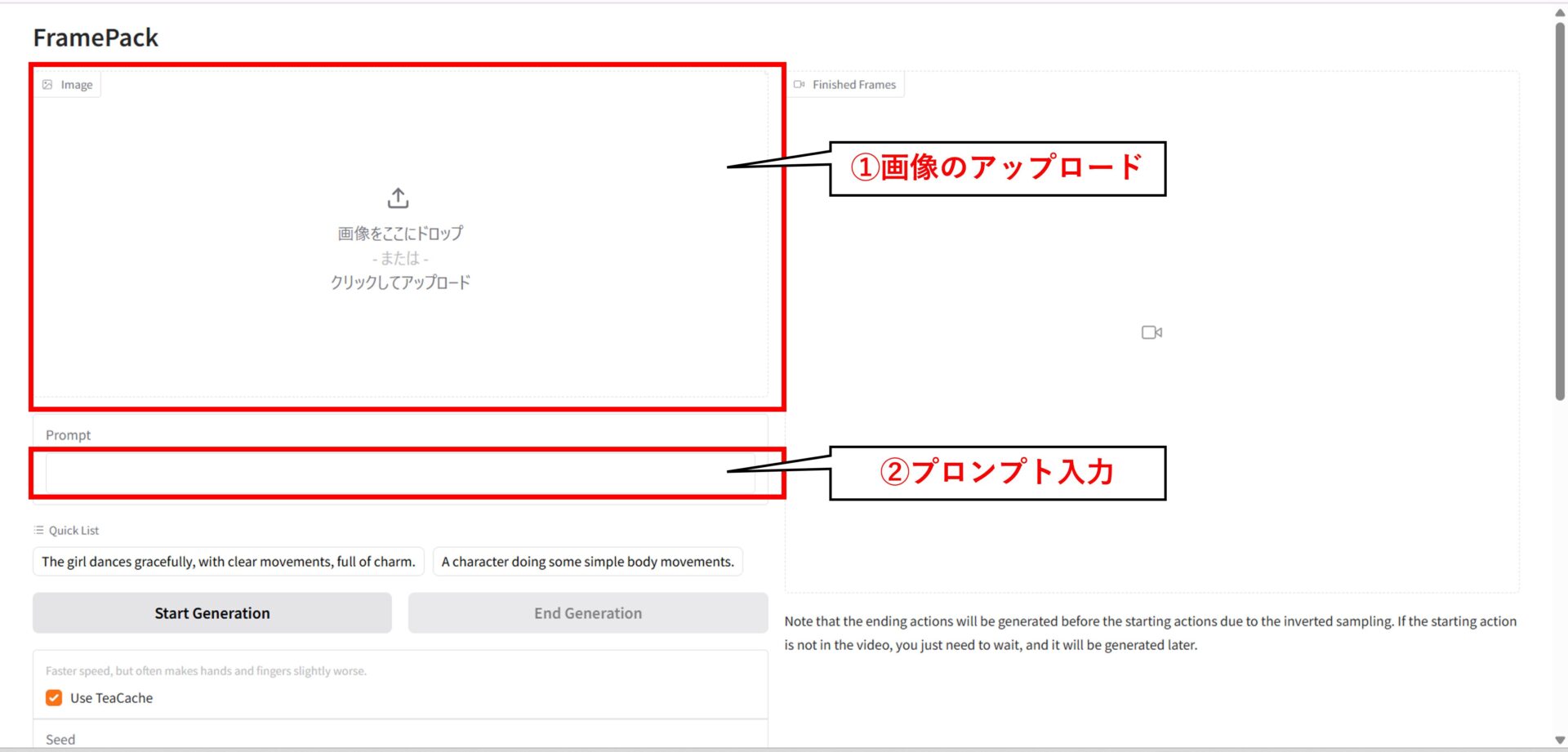

画像の選択とプロンプトの設定

FramePackでは、1枚の静止画とプロンプトを組み合わせて動画を生成します。

①画像のアップロード

画面左上の「Image」欄に画像をドラッグ&ドロップするか、クリックしてアップロードします。人物や風景、アニメキャラなど、どんな画像でも使用可能です。

②プロンプトの入力

「Prompt」欄に、動きや雰囲気の変化を入力します。プロンプトの言語は英語推奨ですが、日本語でもある程度の対応は可能です。

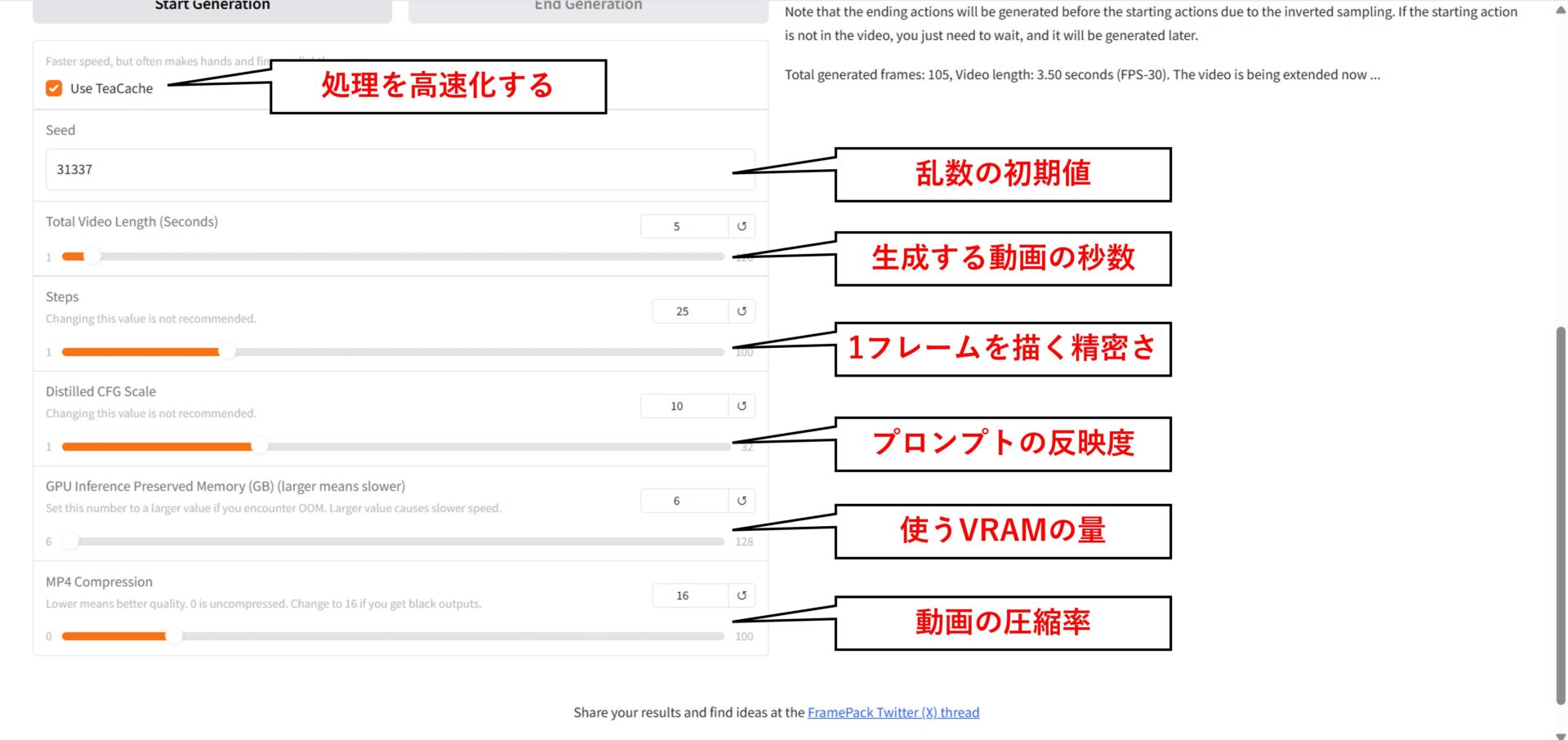

出力設定の調整

FramePackでは、動画の長さや品質、処理速度などを細かく設定できます。初期設定でも十分使えますが、目的やパソコンの性能に応じて調整すると、より理想に近い映像が生成できます。

以下は設定項目や内容、目安の数値をまとめた表です。

| 設定項目 | 説明内容 | 目安の数値 |

|---|---|---|

| Use TeaCache | 処理を高速化するオプション ⇒ONにすると生成が速くなる | ON(精度重視ならOFF) |

| Seed | 乱数の初期値 ⇒動きを再現したい時に固定 | 任意 |

| Total Video Length | 生成する動画の長さ(最大120秒) | 任意 |

| Steps | 1フレームを描く精密さ ⇒高いほど高画質だが遅くなる | 25(高画質:40〜50) |

| Distilled CFG Scale | プロンプトの反映度 ⇒高いほど忠実、低いと自由度が上がる | 7〜10 |

| PyTorch | 使用するVRAMの量 ⇒大きいと安定するが、処理は遅くなる | 6(基本そのまま) |

| MP4 Compression | 出力動画の圧縮率 ⇒0は非圧縮(高画質)、16以上で黒画面回避可 | 0〜16 |

まずは初期設定で試し、必要に応じて段階的に調整してみてください。

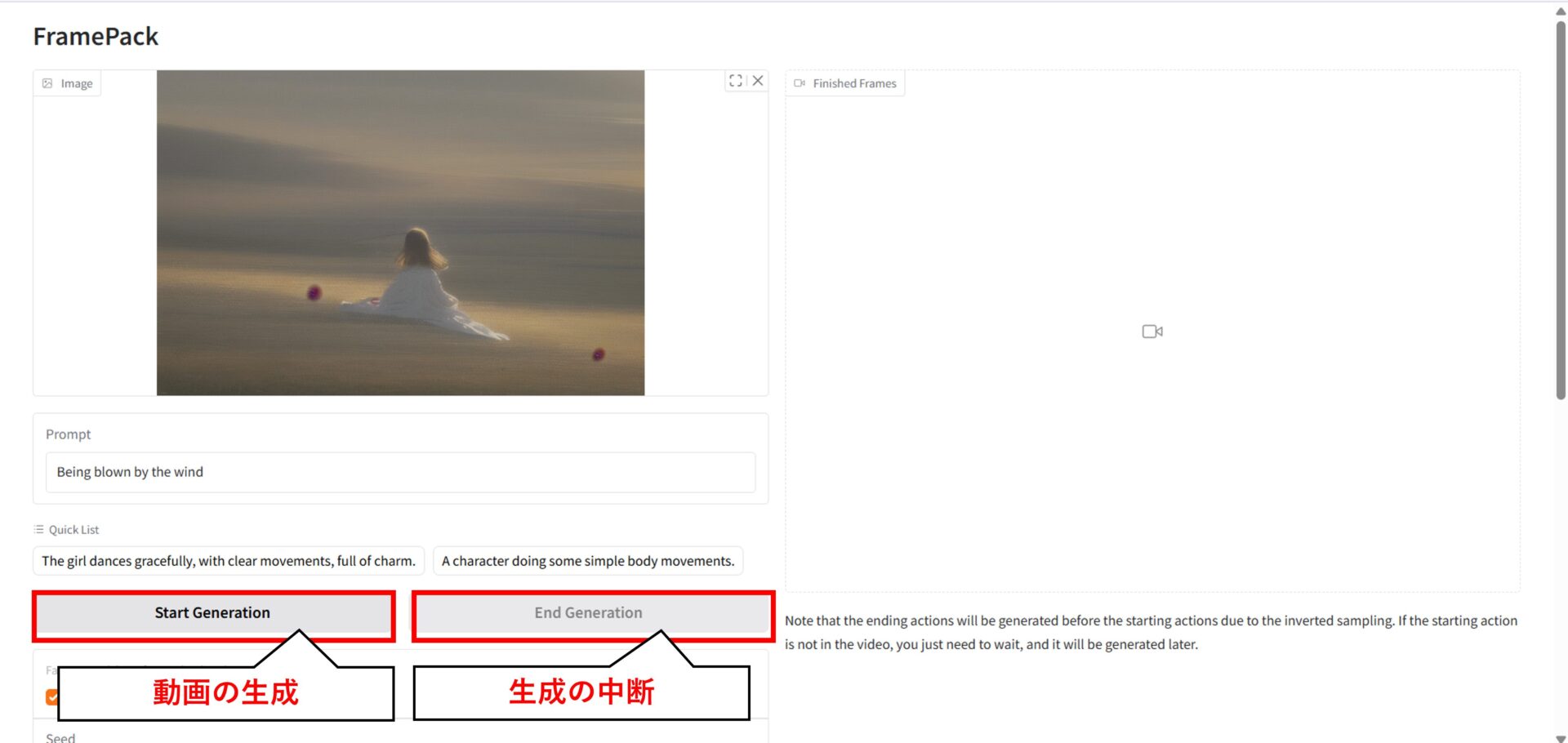

動画の生成と保存

画像とプロンプトの設定が完了したら、動画生成を行います。

①動画の生成や中断

「Start Generation」を選択し、動画を生成します。また、生成を途中で止めたい場合は「End Generation」を選択しましょう。

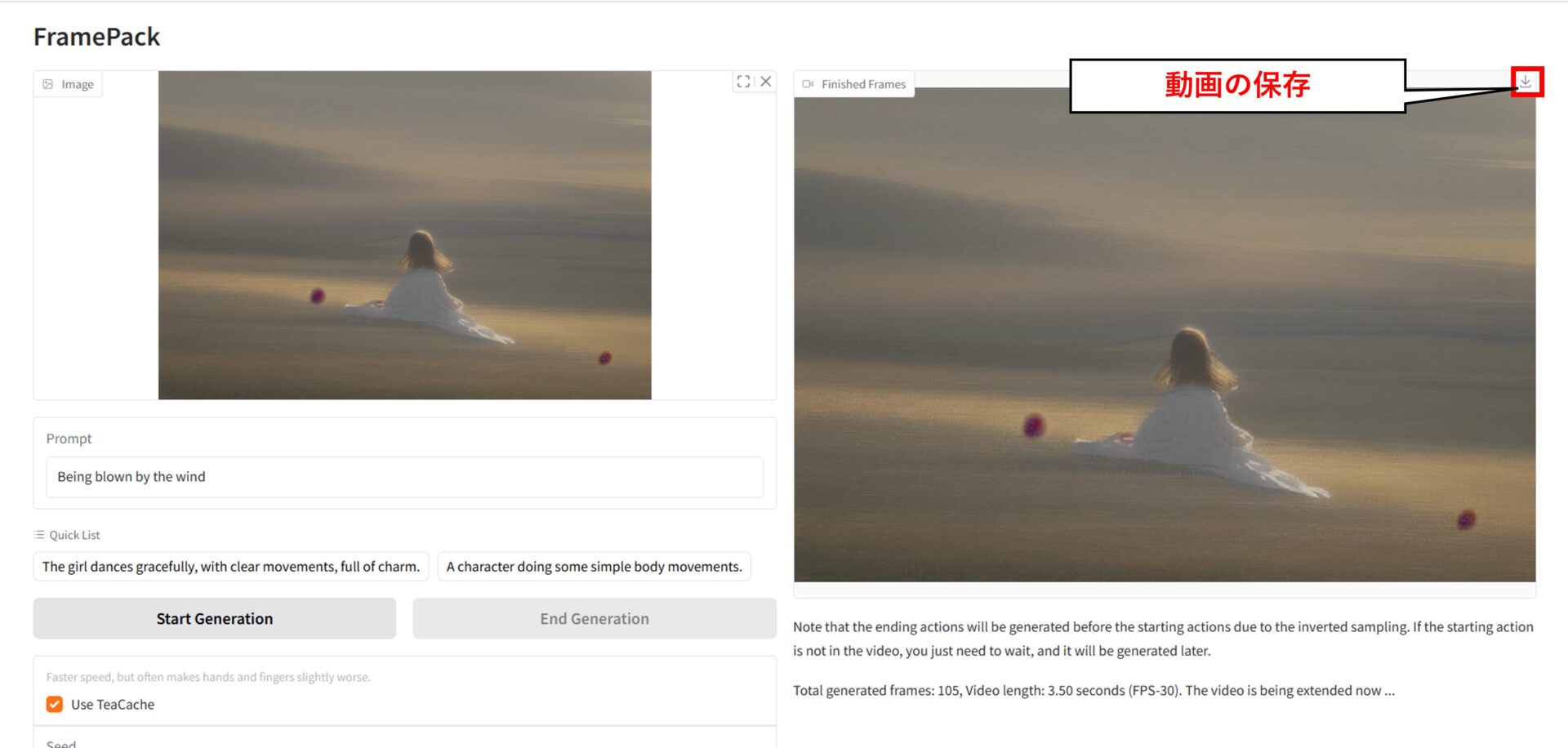

②動画の保存

動画が生成されると、右側のプレビュー欄に再生可能な映像が表示されます。右上の「ダウンロード」から手動で保存できます。保存形式はMP4です。

まずは5秒の短い動画から生成してみましょう。

【実践】筆者がFramePackを使って生成した事例

筆者が実際にFramePackを使って3種類の動画を生成して検証しました。

- 静止画から生成した5秒動画

- 写真から生成した60秒動画

- 人物イラストをもとに生成した120秒動画

使用したプロンプトや生成時間、出力結果などを詳しく解説します。活用イメージとしてぜひ参考にしてみてください。

静止画から生成した5秒動画

まずはFramePackの動作確認として、生成時間が短く、動きの破綻も見つけやすい5秒間の短尺動画から試してみました。

実際に使用したプロンプトや生成された動画は以下の通りです。

The baby penguin happily waddles forward, flapping its small wings.【和訳】子ペンギンが小さな翼をぱたぱたさせながら嬉しそうにヨチヨチ歩く

静止画だったはずのペンギンが自然に歩き出した瞬間「本当に1枚の画像からこれができるのか」と思わず見入ってしまいました。

わずか5秒でも自然な動きを表現できるため、SNSや動画素材、Web演出など幅広い場面で手軽に活用できます。

写真から生成した60秒動画

FramePackがどこまで長い動きを安定して表現できるのかを検証するため、1分間の長尺動画に挑戦しました。

実際に使用したプロンプトや生成された動画は以下の通りです。

The character cheerfully hops in place while moving its big eyes left and right.【和訳】キャラクターがその場で元気よくぴょんぴょん跳ねながら、大きな目を左右に動かす

1枚の写真のキャラクターに動きが加わり、机の上の置き物が急に生きてる存在のように感じられました。

60秒の中で動きをしっかり見せられるため、マスコットキャラを使ったキャンペーンや商品紹介にも活用できます。

人物イラストをもとに生成した120秒動画

FramePackの最大対応時間である120秒の映像が、どこまで破綻なく描かれるのかを検証するため、あえて2分間の長尺動画に挑戦しました。

実際に使用したプロンプトや生成された動画は以下の通りです。

The elegant lady slowly enjoys her meal, delicately taking bites of the burger and fries, while maintaining her graceful posture.【和訳】優雅な女性が姿勢を保ちながら、ハンバーガーとポテトを上品に少しずつ口に運ぶ

女性がハンバーガーに口を運ぶ動作はしっかり再現されていましたが、ハンバーガーが減っていく様子やポテトを食べる動作は確認できませんでした。

冒頭の数十秒は色味がやや強く、光の当たり方にも違和感がありましたが、全体としては破綻なく仕上がっていました。

2分間の中でストーリー性のある動きを自然に描けるため、デモ映像やプロモーションの一場面として活用できます。

FramePackを使う時の注意点

FramePackを使う時に注意すべき点は以下の3つです。

- 長尺動画生成には時間がかかる

- モデルダウンロードが失敗することがある

- 「TeaCache」機能は出力品質が低下する

モデル導入や長尺生成でつまずかないために、3つの注意点は事前に確認しておきましょう。

長尺動画生成には時間がかかる

FramePackで長尺の動画を生成する場合、生成処理に要する時間に十分な注意が必要です。

動画は数千枚のフレームで構成されており、1フレームずつ順に生成される仕組み上、動画の長さに比例して処理時間が増加します。

たとえば、RTX4090クラスのGPUでも、1分間で30fpsの動画を生成するには、およそ75分の処理時間を要します。

そのため、最初から数分単位の動画を生成するのではなく、まず5秒程度の動画で動作確認を行い、段階的に生成時間を延ばすようにしましょう。

「質の高いプロンプトでAIの能力をもっと引き出したい」「プロンプトのコツを知りたい」という方に向けて、この記事では「【超時短】プロンプト150選」を用意しています。

この資料ではジャンル別に150個のプロンプトを紹介しています。また、プロンプトエンジニアリングのコツも紹介しており、実践的な資料が欲しい方にも適しています。

無料で受け取れますが、期間限定で予告なく配布を終了することがありますので、今のうちに受け取ってプロンプトをマスターしましょう!

30秒で簡単受取!

無料で今すぐもらうモデルダウンロードが失敗することがある

初回利用時は、モデルファイルのダウンロードに失敗する場合があるため注意が必要です。

モデルは大容量であり、通信環境の影響やサーバー側の応答遅延によって、ダウンロードが途中で止まったりタイムアウトしたりする事例が報告されています。

筆者も初回起動時にモデルの取得で複数回失敗しました。

万が一、想定外のエラーが発生した時は、エラーメッセージの内容をChatGPTに入力し、原因や解決策を出力してくれます。

「TeaCache」機能は出力品質が低下する

「TeaCache」機能は生成処理を高速化できますが、出力品質が低下する場合もあるため注意が必要です。

高速化の実現には、推論プロセスの一部を簡略化する仕組みが使われており、再現性や描写の正確性に影響を及ぼす場合があります。

開発者は、公式ドキュメント内で「TeaCacheは画質が劣化する可能性がある」と明言しています。

下記は「TeaCache」機能を有効にした場合と無効にした場合の出力比較です。

動画の出典:FramePack

高品質な出力を求める場合や公開用途の動画を生成する時は「TeaCache」機能を無効にした状態で出力しましょう。

FramePackを使って好きな画像を動かしてみよう!

FramePackは、静止画1枚から最大120秒の動画を生成できるAIツールです。

wanを使用された経験がある方は、FramePackの「長時間でも安定した出力」や「一貫性のある映像表現」に驚きを感じられるでしょう。

今後は、高解像度対応や音声同期、複数画像を用いたストーリー生成機能の追加も予定されており、さらなる進化が期待されています。

本記事を参考に、まずは手元の画像を使ってFramePackで動画を生成してみましょう。

「質の高いプロンプトでAIの能力をもっと引き出したい」「プロンプトのコツを知りたい」という方に向けて、この記事では「【超時短】プロンプト150選」を用意しています。

この資料ではジャンル別に150個のプロンプトを紹介しています。また、プロンプトエンジニアリングのコツも紹介しており、実践的な資料が欲しい方にも適しています。

無料で受け取れますが、期間限定で予告なく配布を終了することがありますので、今のうちに受け取ってプロンプトをマスターしましょう!

30秒で簡単受取!

無料で今すぐもらう執筆者

西啓汰

大学での学びと並行して活動するフリーランスのSEO/Webライター。

研究テーマは「Music to Video」。音楽の歌詞や曲調を分析し、自動で映像を生成する仕組みの開発中。

生成AIツールを実際に触れ、体験を通じて得た知見を活かし、価値を届けるライティングを実践。

趣味は野球観戦とラジオ聴取。

30秒で簡単受取!

無料で今すぐもらう